#2 – INTRODUZIONE ALLA SEO – Search Engine Optimization

..prima di partire..

![]() Una guida gratuita di SEO per principianti redatta da Giorgio Trave

Una guida gratuita di SEO per principianti redatta da Giorgio Trave

Tutto il SEO al volo con Paolo Libera

La stesura dei contenuti di questa pagina riprende le linee guida dello studio dei professionisti SEO STUDIO SAMO

La SEO?

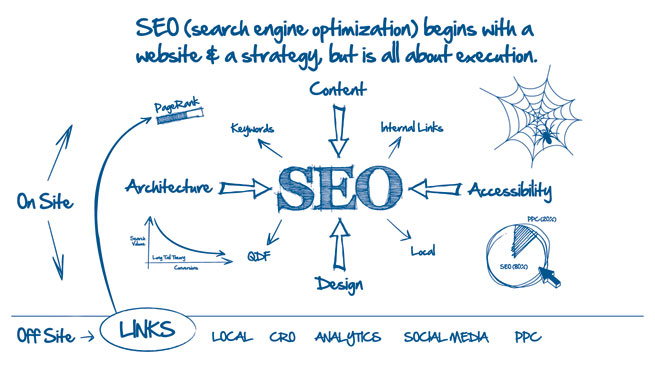

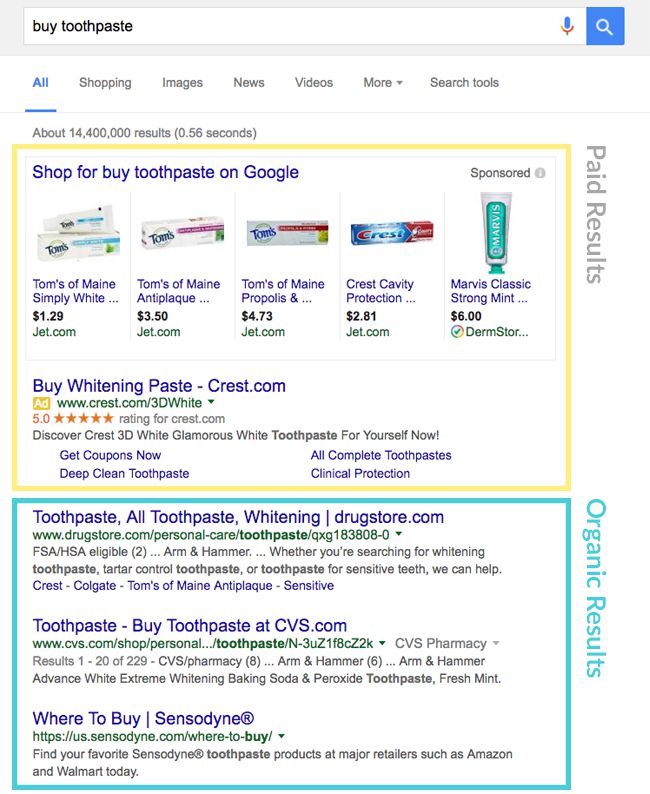

SEO è quell’insieme di strategie e pratiche volte ad aumentare la visibilità di un sito internet migliorandone la posizione nelle classifiche dei motori di ricerca, nei risultati non a pagamento, detti risultati organici (organic result nell’immagine).

SEO è quell’insieme di strategie e pratiche volte ad aumentare la visibilità di un sito internet migliorandone la posizione nelle classifiche dei motori di ricerca, nei risultati non a pagamento, detti risultati organici (organic result nell’immagine).

S.E.O. sta per Search Engine Optimization, tradotto letteralmente: “ottimizzazione per i motori di ricerca“.

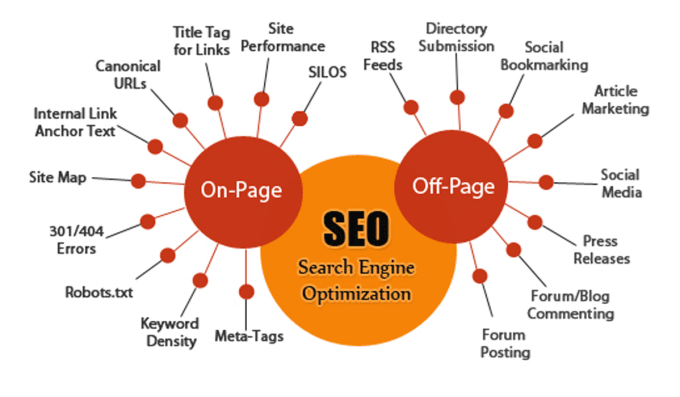

Queste pratiche sono molteplici e riguardano diversi aspetti di un sito web: l’ottimizzazione della struttura del sito, del codice HTML, dei contenuti testuali, la gestione dei link in entrata ( backlink) ed in uscita (che dal tuo sito puntano verso altri), la velocità del sito.

Tutto si basa sulla coerenza fra la “query” di ricerca e il sito di atterraggio, che deve essere attinente e autorevole (ranking).

Poiché Google è il motore di ricerca di gran lunga più utilizzato al mondo, la maggior parte delle attività SEO riguardano lo studio dell’algoritmo di Google e dei suoi periodici aggiornamenti, e le relative azioni per rendere i siti più graditi a tale algoritmo.

Il SEO è invece il professionista che si occupa della SEO

2 – DIZIONARIO SEO

-

- SERP: “Search Engine Result Page”, è la pagina dei risultati del motore di ricerca che riproduce Google in base alla query e che compare dopo che si sono inseriti i termine di ricerca

-

- Query: è una qualunque ricerca effettuata sul motore, testuale o vocale

-

- Keywords: “parole chiave”: sono le parole inserite nel campo di ricerca Per keyword si intendono non soltanto singole parole ma anche stringhe di testo come “corso di seo torino” o voglio fare un corso di seo.

-

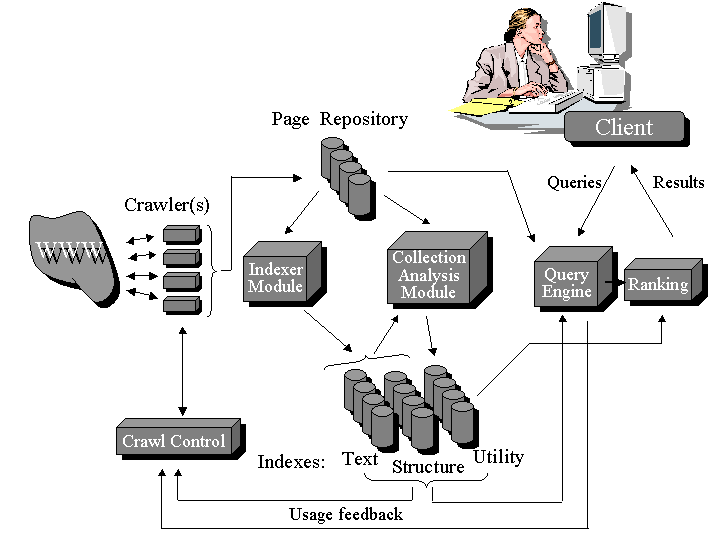

- Robot: (detto anche spider o crawler), è il software che i motori di ricerca utilizzano per analizzare tutti i siti della rete. I robot scandagliano continuamente tutta la rete, passando di pagina in pagina per mezzo dei link. Effettuano una copia testuale di tutti i documenti visitati e li inseriscono in un indice (vedi indicizzazione). Il robot di Google si chiama Googlebot.

-

- Indicizzazione: è il processo mediante il quale il robot aggiunge il materiale al database del suo motore di ricerca per restituirlo poi, ordinato in un raking in base alla pertinenza con la chiave di ricerca.

-

- Ranking: è la classifica dei risultati rispetto ad una determinata query. Quando inseriamo una keyword, il motore di ricerca restituisce una SERP di risultati ordinati in base alla pertinenza dei documenti indicizzati rispetto a tale parola chiave. Ranking è inoltre sinonimo di posizionamento (vedi), in ambito SEO si dice “fattore di ranking” un qualunque elemento, interno o esterno al sito, che influenza la posizione in classifica.

-

- Ottimizzazione: sono i meccanismi che rendono il sito web più facilmente reperibile e indicizzabile dai robot

-

- Posizionamento: consiste nel migliorare la posizione di un sito/pagina web nel ranking dei motori di ricerca in relazione a determinate keyword.

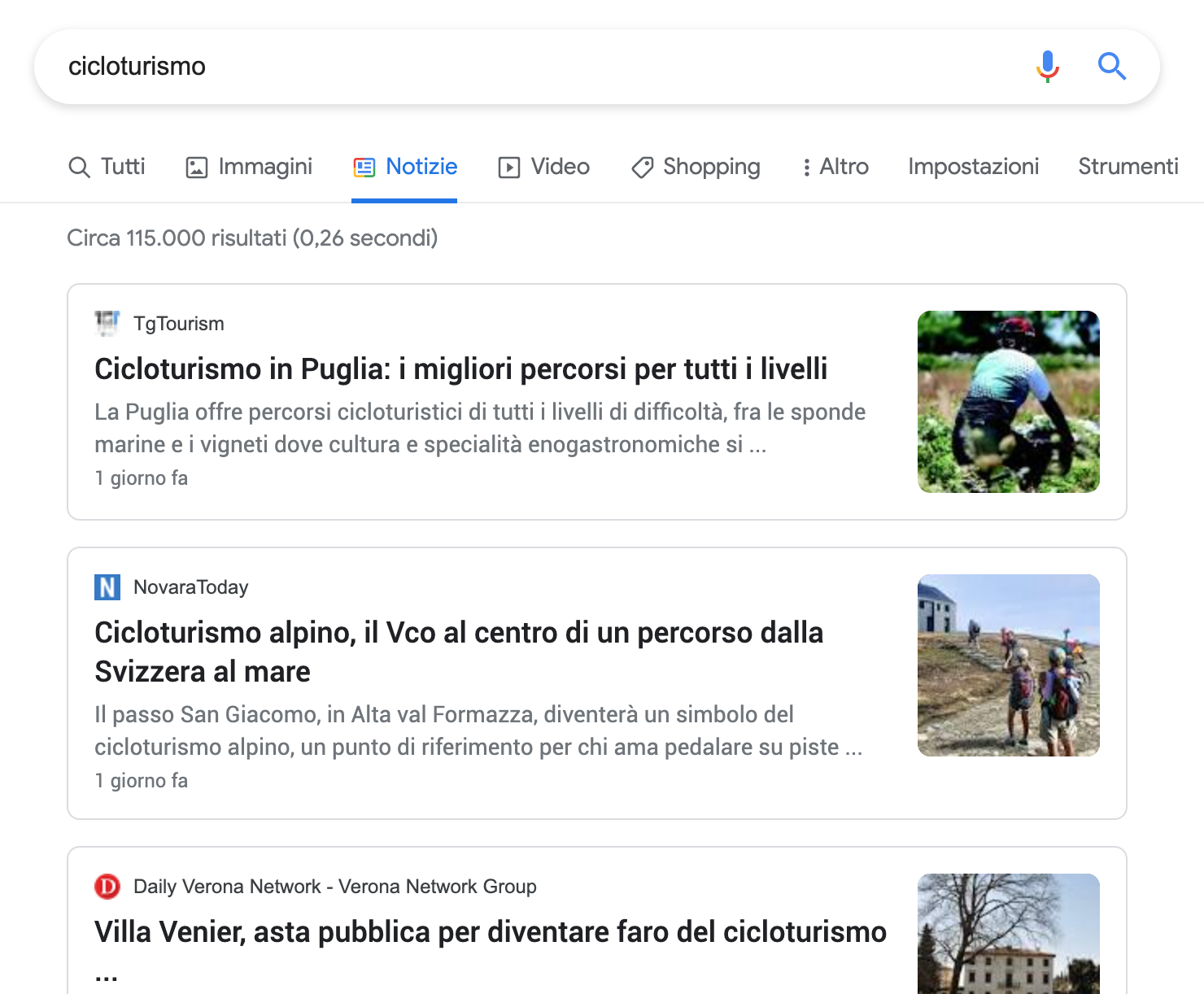

3 – LA SEARCH ENGINE RESEARCH PAGE

Il corpo della SERP (Search Engine Research Page)

Rispetto a solo pochi anni fa, come già detto, la SERP di Google si è notevolmente arricchita e, da un punto di vista SEO, decisamente complicata.

Non si tratta più di un semplice elenco di URL, ma di una pagina che, a seconda della query, fornisce risultati attraverso:

->diverse modalità multimediali (immagini, video, mappe, notizie);

->diverse funzionalità (Knowledge Graph, segnalazioni di recensioni e commenti, box di risposte di Google, ecc);

->personalizzazioni e geolocalizzazioni (Google cerca di fornire risposte ritagliandole sull’utente e sulla sua localizzazione geografica o linguistica).

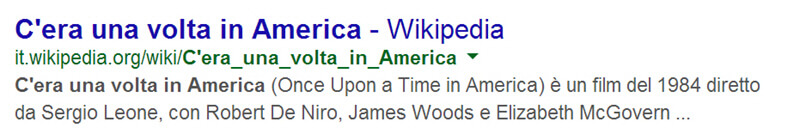

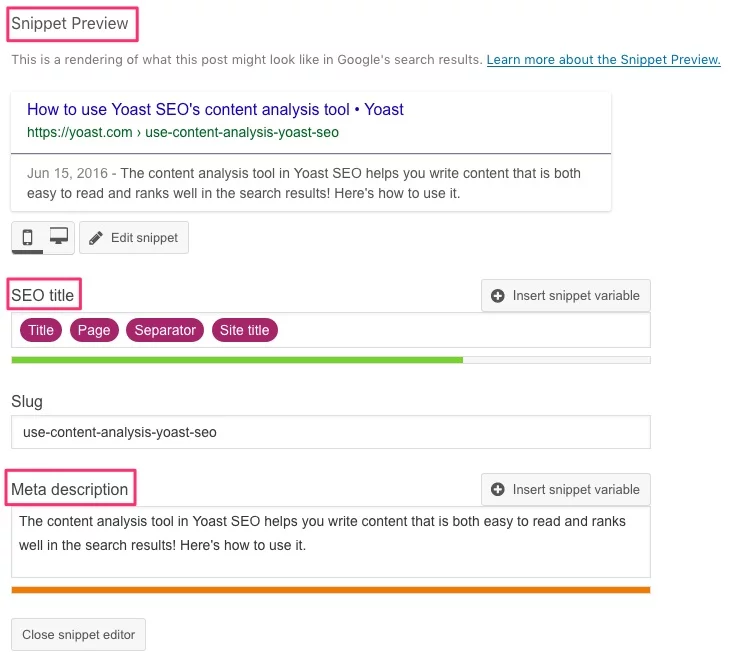

Lo SNIPPET: il risultato della query è composto da tre elementi:

- – il titolo della pagina: cliccandovi accediamo alla pagina stessa;

- – l’URL: vediamo in verde l’indirizzo della pagina Web; in alternativa possiamo trovare il percorso della pagina (è il breadcrumb, letteralmente “briciola di pane”, cioè il percorso di navigazione all’interno del sito fino a quella pagina; questo dà la possibilità all’utente, ad esempio, di accedere alla categoria corrispondente a quella pagina anziché selezionare la pagina stessa);

- – description: si tratta di una descrizione della pagina che può essere prelevata dalla cosiddetta meta description o, in alternativa, viene creato in automatico da Google partendo da un estratto (meta description, paragrafo) della pagina che ritiene attinente alla query. Google da qualche anno ha implementato anche i rich snippet che aggiungono informazioni ai risultati

4 – COME STA CAMBIANDO LA SEO NEL 2020-21

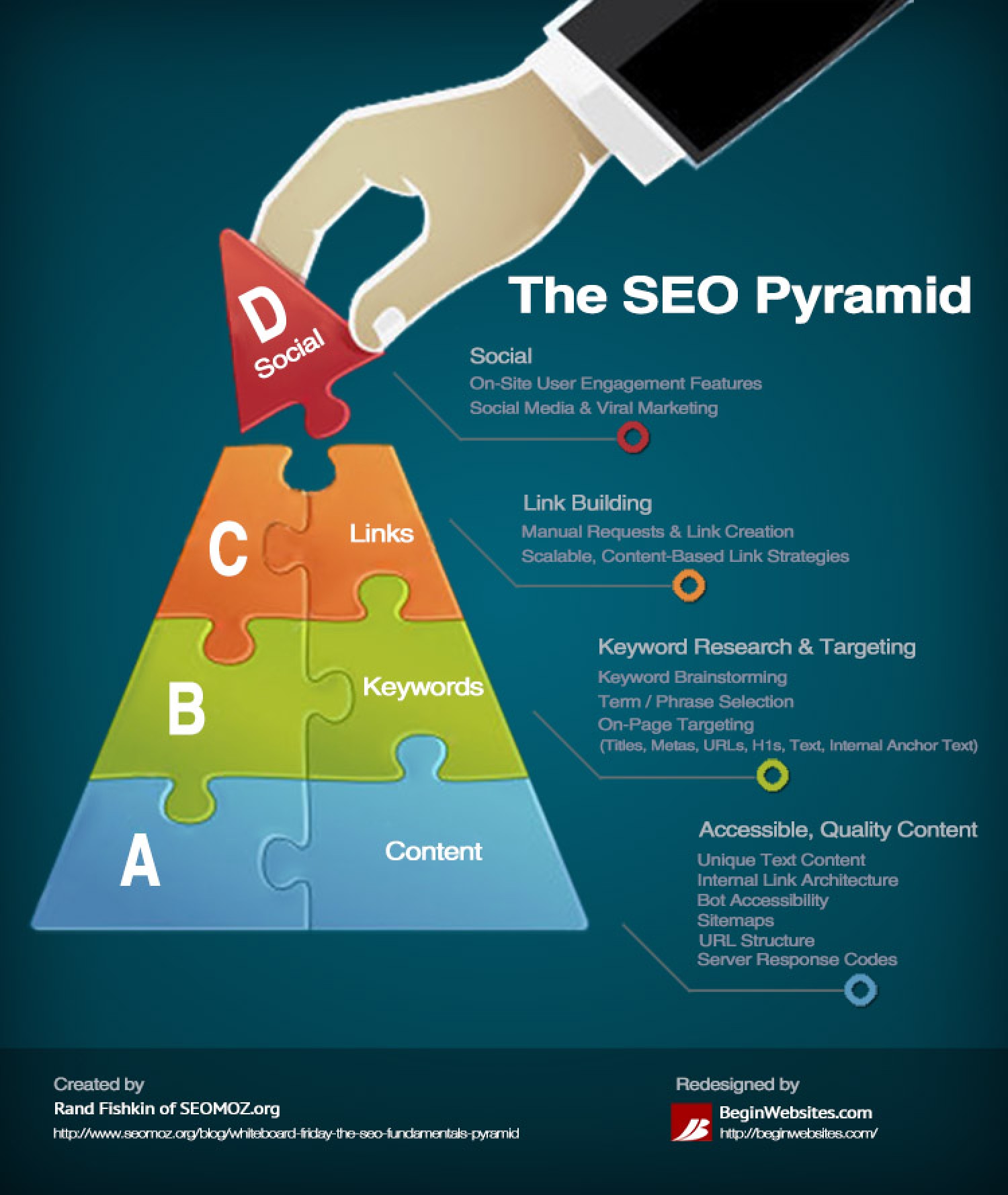

Alla base di una buona indicizzazione su Google ci sono sempre state due pratiche principali: le pratiche offsite, cioè il link building (i link in ingresso) e quelle onsite, cioè la strutturazione dei contenuti e del codice.

I link in entrata sono sempre stati alla base della capacità del motore di ricerca d’interpretare e assegnare un ranking.

E in questo modo la ricerca organica tende sempre di più a scendere benché in realtà quel che sta accadendo è che tutte le query che evocano riferimenti di business avranno sempre meno risposta organica mentre le ricerche puramente informative privilegeranno ancora una serp organica.

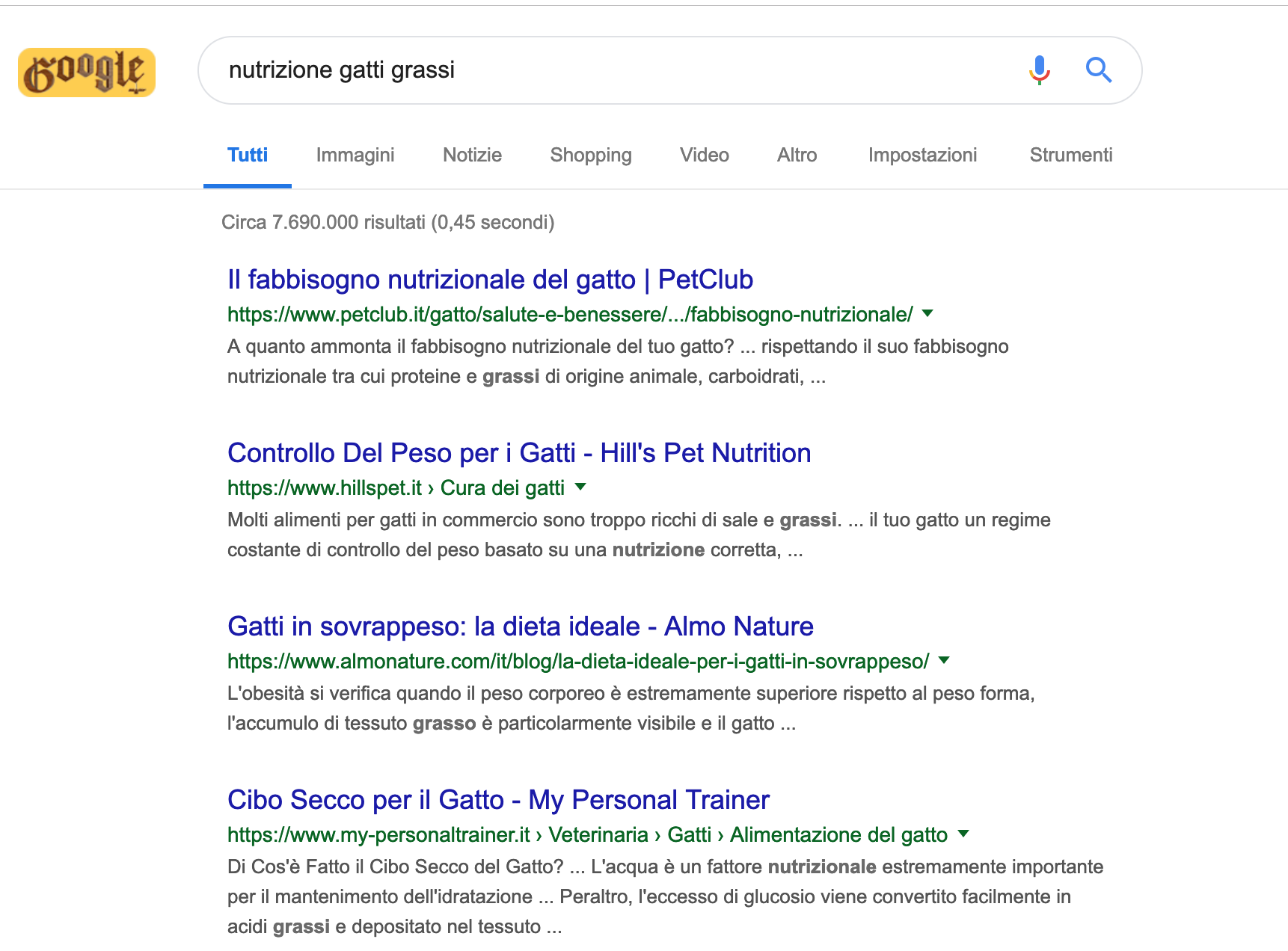

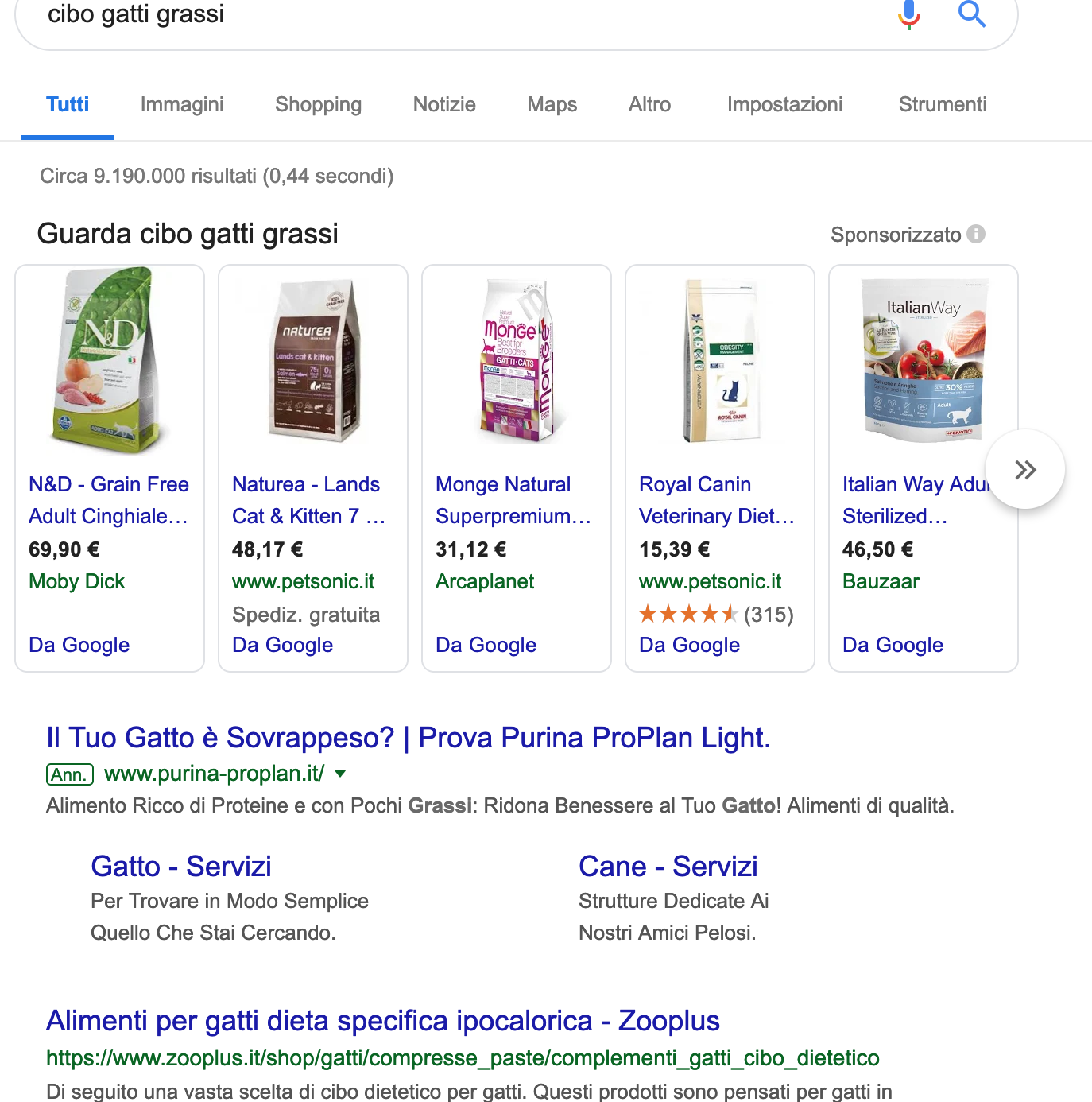

Ad esempio “nutrizione gatti grassi” viene interpretata come una ricerca informativa (e non attiva neanche degli annunci ADS)

Mentre cibo gatti grassi evoca di più una richiesta legata al business e infatti Google ci infila la sua piattaforma Google Merchant (che sta in cima alla SERP), gli annunci ADS e poi l’organico.

Ma quali sono questi grossi filoni di cambiamento?

![]() Ne parla approfonditamente l’esperto SEO Serra qua.

Ne parla approfonditamente l’esperto SEO Serra qua.

In linea di massima potremmo riassumere dicendo che Google vuole:

Richieste vocali

Interagire sempre di più con le richieste vocali e fornire le risposte a bisogni specifici che vengono espressi attraverso formule colloquiali. Pensiamo all’ok Google dei dispositivi android e a Google Home. Ne parla approfonditamente Ninja Marketing qui. Nella pratica cambierà molto la strategia di base anche a livello di seo copywriting. Meno keyword e più concetti. Più longtail e più local business.

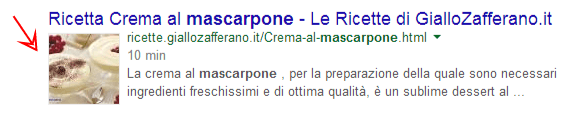

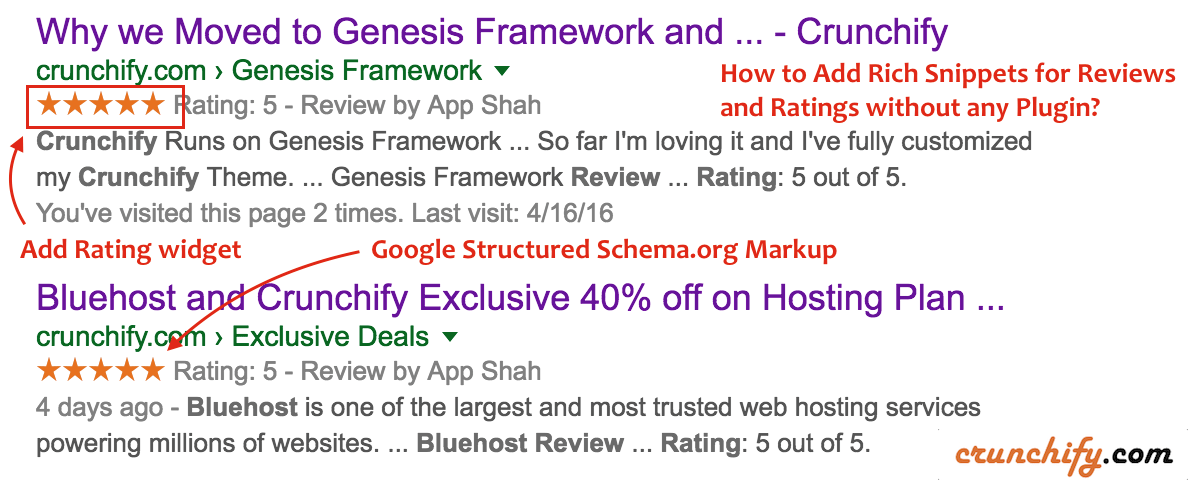

Dati Strutturati (rich snippet e schema.org)

Fornire risposte più strutturate e più utili per l’utente. Qui entrano in scena i rich snippet e schema.org. Il Rich Snippet, arricchisce il risultato dello snippet normale di google (il sito nella SERP con “titolo”, “url” e “descrizione”) con elementi aggiuntivi che verranno visualizzati dall’utente su Google che, come vedremo dopo, possono essere stelline (valutazioni/recensioni), prezzi, video e nominativo dell’autore che ha realizzato tal contenuto. Schema.org è il nuovo vocabolario utilizzato dai crawler per interpretare le informazioni sui siti Web e sulle varie pagine. L’obiettivo è quello di migliorare la ricerca web creando uno schema di markup dei dati strutturati per gli snippet supportato dai principali motori di ricerca relativi al “rating”, alle “persone”, ai “luoghi”, agli “eventi”, le “ricette” ecc.. Ecco un esempio di come e dove implementare i markup di schema.org:

Schema.org è il nuovo vocabolario utilizzato dai crawler per interpretare le informazioni sui siti Web e sulle varie pagine. L’obiettivo è quello di migliorare la ricerca web creando uno schema di markup dei dati strutturati per gli snippet supportato dai principali motori di ricerca relativi al “rating”, alle “persone”, ai “luoghi”, agli “eventi”, le “ricette” ecc.. Ecco un esempio di come e dove implementare i markup di schema.org:

![]() Schema.org e richsnippet su wordpress a mano e con plugin

Schema.org e richsnippet su wordpress a mano e con plugin

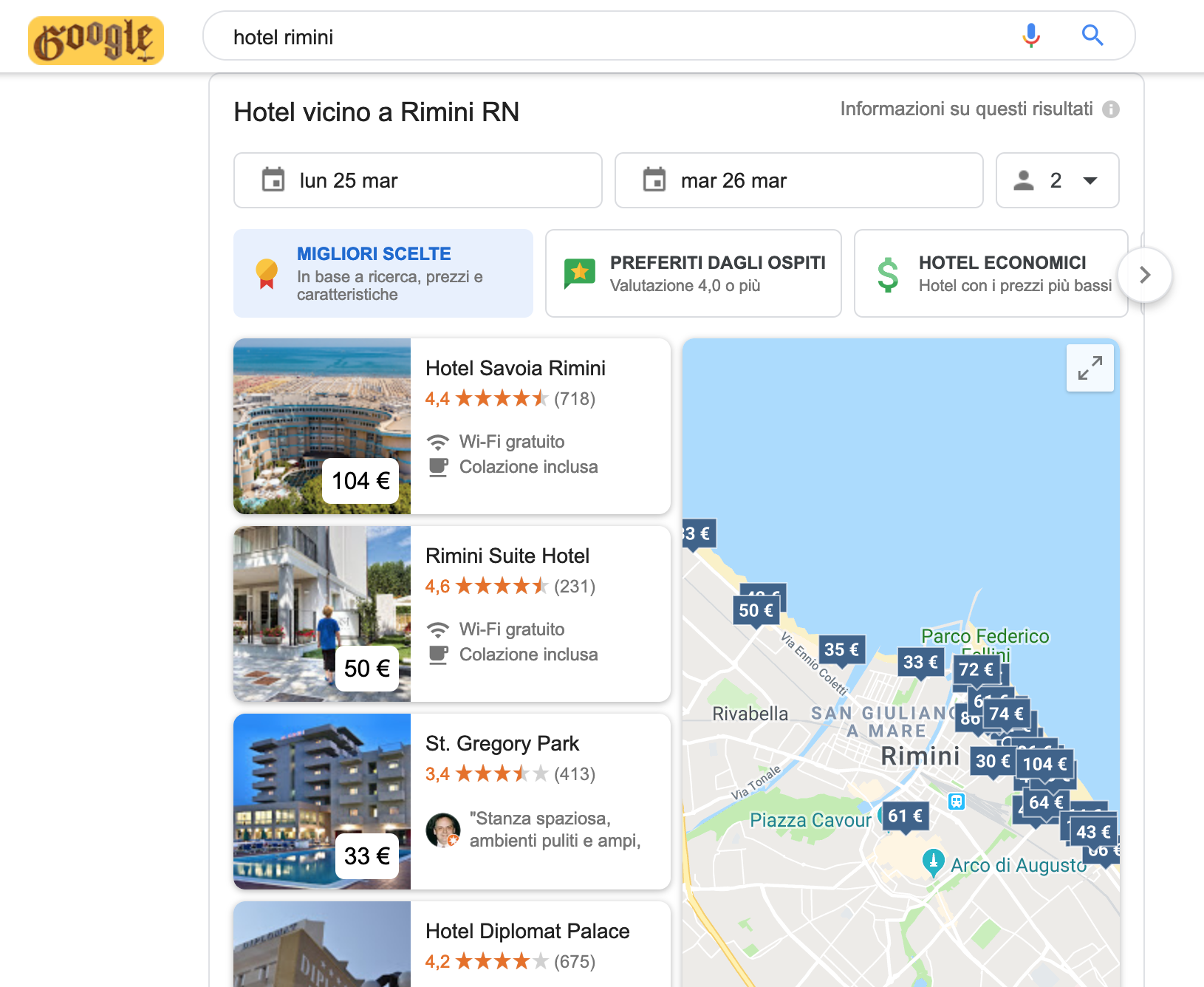

Google generated content

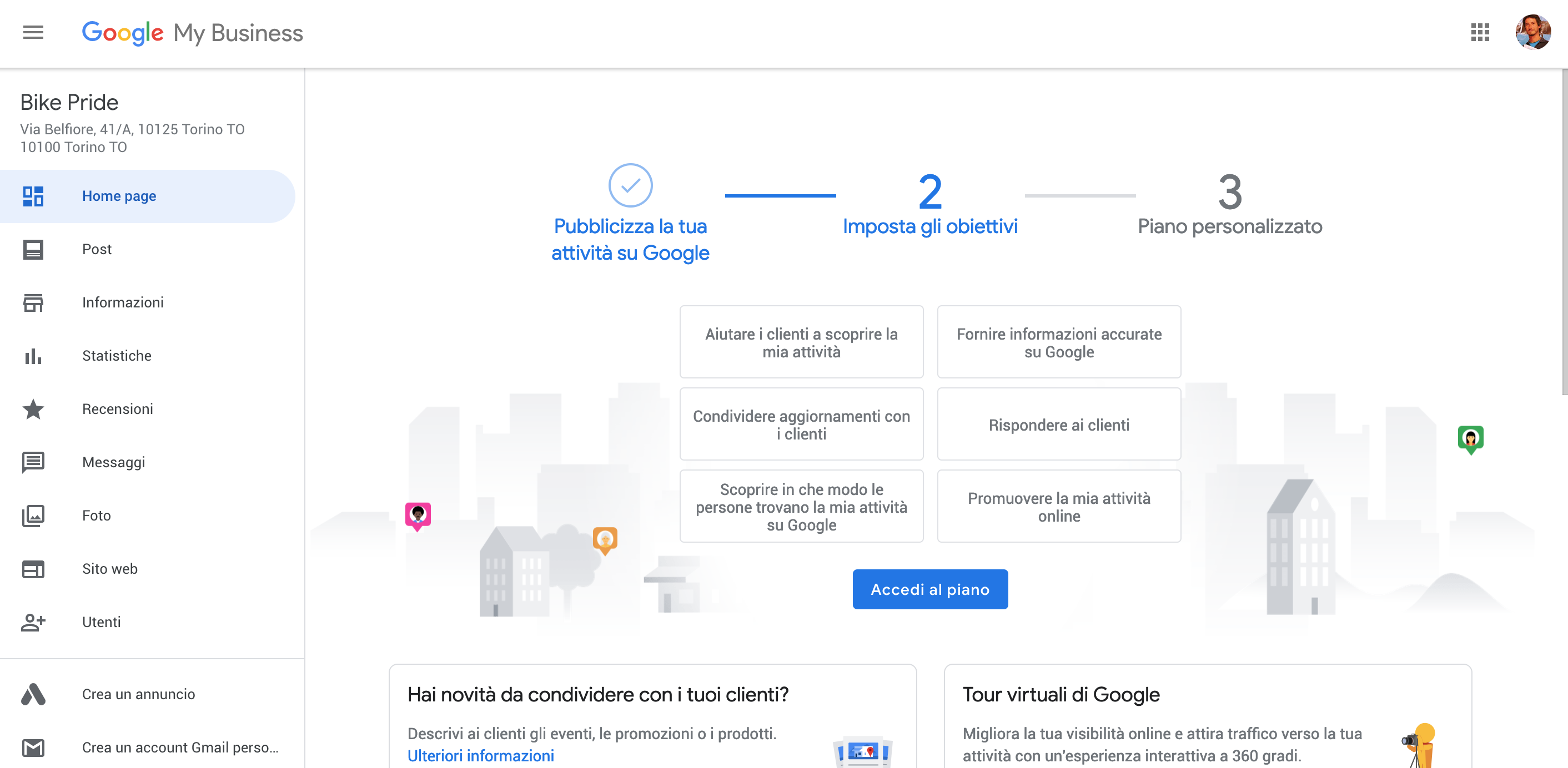

Come anticipato con schema.org fornire risposte generate direttamente da Google (grazie ad integrazione Google MyBusiness e Google ADS) come quella qua sotto relativa alla query Hotel+Rimini.

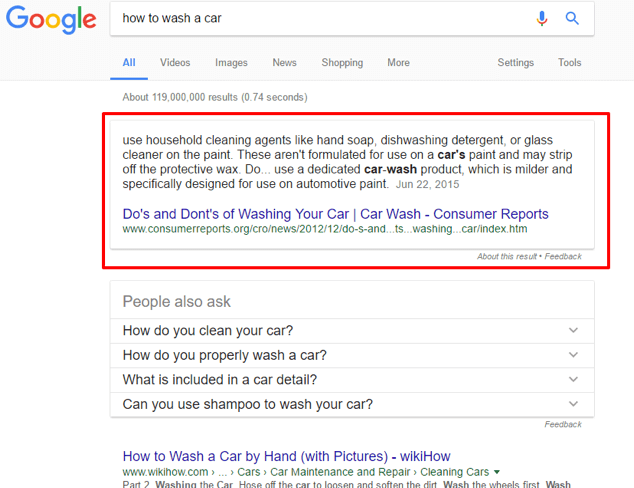

Featured snippet & Position Zero

A proposito di Contenuto generato da Google.. featured snippet è lo snippet restituito per una specifica query, mostrato immediatamente sopra ai risultati organici e incorniciato in un apposito riquadro. Può essere solo testuale oppure presentarsi insieme a un’immagine o un video. Viene chiamato anche risultato zero, perché non si sostituisce al primo risultato organico di Google, ma si aggiunge agli altri elementi della Serp.

Lo scopo del featured snippet è fornire la risposta migliore all’esigenza dell’utente, spesso direttamente in Serp. Generalmente, infatti, i featured snippet rappresentano delle risposte a specifiche domande, siano esse esplicite o implicite (es. come lavare una macchina).

In questi casi non è neanche necessario cliccare sul risultato per soddisfare la propria esigenza informativa. Il featured snippet risponde perfettamente alla nostra domanda.

In altri casi invece il risultato zero può presentarsi come risultato di query informazionali più generiche, che l’utente può approfondire cliccando sullo snippet.

Google sceglie se e quali featured snippet mostrare in maniera del tutto arbitraria. In alcune Serp questi risultati sono completamente assenti. Quindi non esiste un modo sicuro per raggiungere il tanto ambito risultato zero.

Il metodo per riuscire ad essere in position zero grazie ai featured snippet è lavorare al meglio con i dati strutturati (vedi capitolo su rich snippet in SEO onsite in qusta pagina).

Il secondo consiglio è quello di lavorare sul search intent dell’utente (vedi intento di ricerca su questa pagina), cercando di fornire, a seconda dei casi, la risposta migliore alla sua domanda o il contenuto più esaustivo possibile.

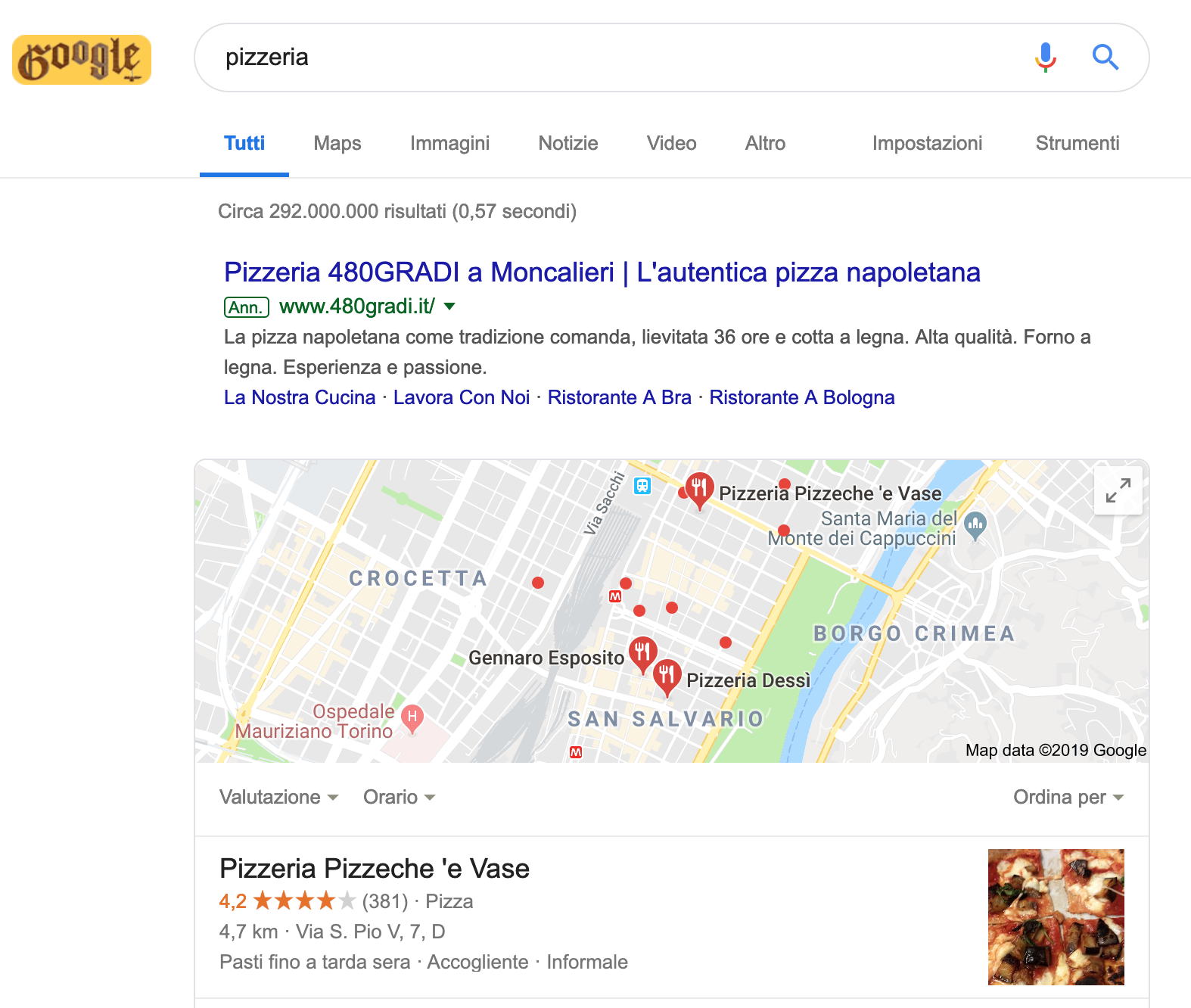

Local search

Già da tempo Google fornisce risposte geolocalizzate che intercettano i dati di Google My Business. Ormai non è più necessario cercare pizzeria torino.. è sufficiente scrivere pizzeria!

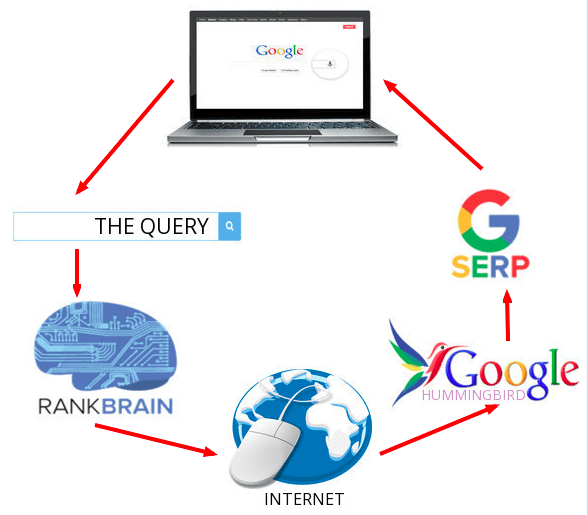

Semantic search

Interpretare i contenuti dei siti web. Capire il contesto insomma. E qui ci addentriamo nel web semantico e nel mondo degli algoritmi di Google e in particolare di RankBrain.Rankbrain è un componente del più grosso algoritmo Hummingbird, che tra le altre cose custodisce altri algoritmi dei quali hai già sicuramente sentito parlare, come per esempio Panda, Pigeon, Penguin e Pirata.

Nella pratica per assecondare le novità di Google è necessario lavorare sulla qualità delle proprie pagine web. Cosa significa?

Aumentare il CTR (click trough rate, cioè il numero di click sul sito rispetto al numero delle visualizzazioni dello stesso) delle singole pagine

Aumentare le conversioni che devono essere impostate su ADS o Analytics (ad esempio se ho una landing page che fa lead generation google vuole che la mia pagina produca molti lead!)

Lavorare su SEO Copywriting emozionale. Insomma non più “Cibo in scatola per Gatti Grassi – FattyCatPlus – Acquista ora” ma “Il tuo gatto tornerà felice e smilzo con FattyCatPlus, il cibo per gatti in scatola che piace al 93% dei gatti sovrappeso.

5 – SEO: COME FUNZIONA UN MOTORE DI RICERCA

Uno sguardo dentro Google

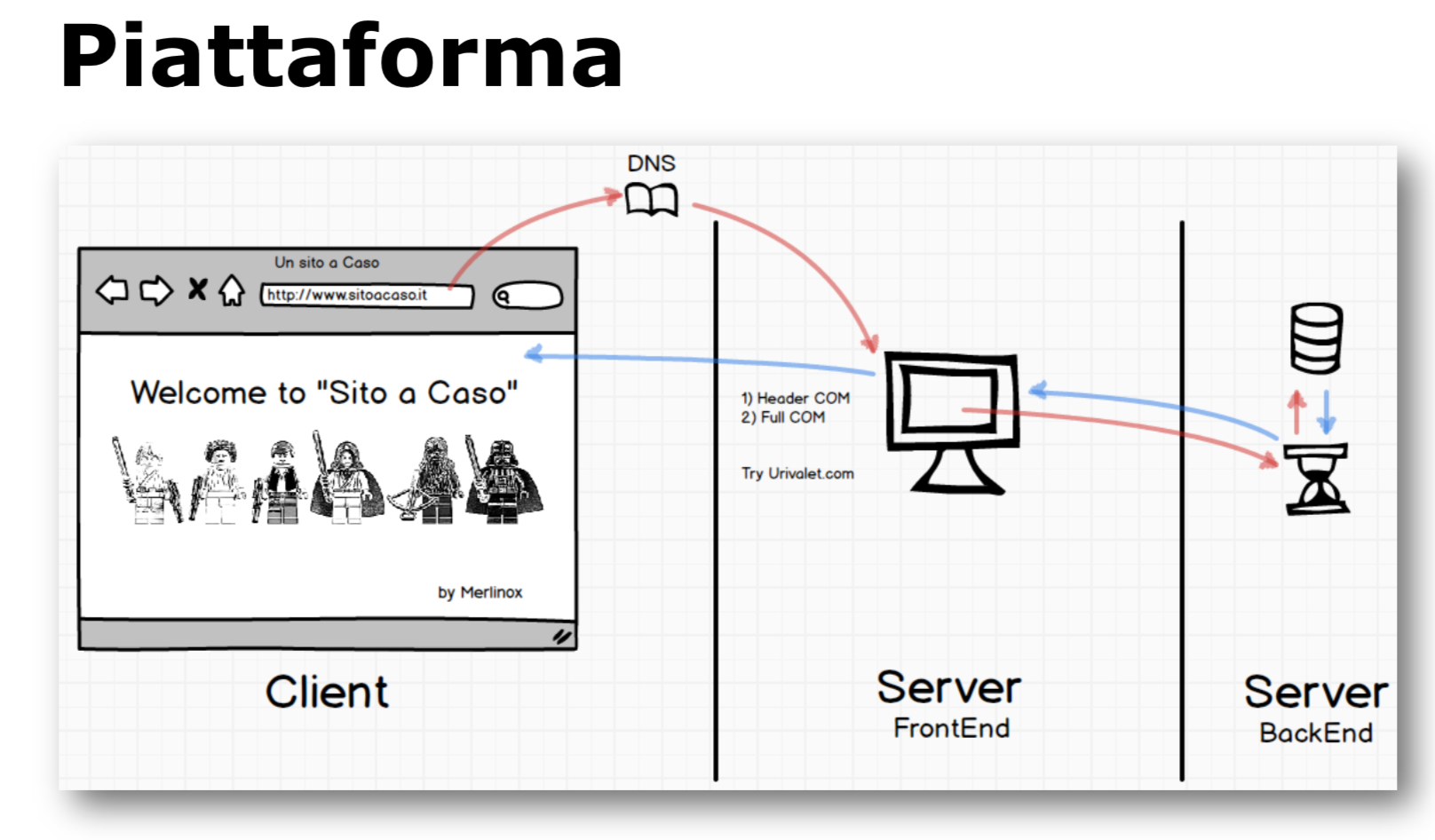

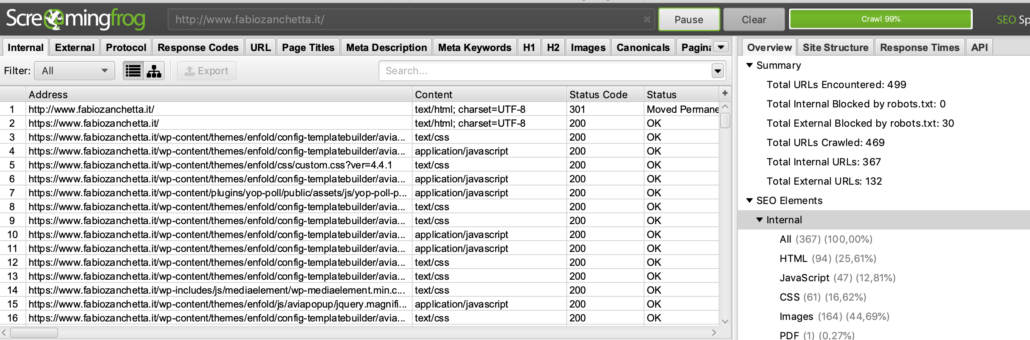

Per praticare ogni attività SEO è necessario in primis capire come opera un motore di ricerca. Un motore di ricerca non opera sui server ma ha possibilità di scansionare solo i contenuti renderizzati. Insomma Google lavora solo sul primo settore dell’immagine qui sopra!

![]() Approfondimento tecnico su come funziona un motore di ricerca nelle sue tre fasi:

Approfondimento tecnico su come funziona un motore di ricerca nelle sue tre fasi:

-

- Scansione (crawl): esegue ricerche su Internet per cercare contenuti, controllando il codice / i contenuti per ciascun URL trovato.

-

- Indicizzazione (index): archivia e organizza i contenuti trovati durante il processo di scansione. Una volta che una pagina è nell’indice, viene processata per essere visualizzata come risultato per le query pertinenti.

-

- Ordinamento e Ranking: fornisce i contenuti che risponderanno meglio alla query di un ricercatore, il che significa che i risultati sono ordinati dal più rilevante al meno rilevante e viene creata la SERP.

Per approfondire puoi leggere quest’articolo sui motori di ricerca.

Gli algoritmi di GOOGLE

Google aggiorna di tanto in tanto il suo algoritmo, raffinandolo sempre più, per dare agli utenti risultati migliori ed evitare la manipolazione dei risultati da parte dei SEO meno corretti (vedi Black Hat) e di presentare tra i primi risultati le pagine che diano effettivamente un valore agli utenti.

Alcuni tra i più significativi sono stati Google Panda nel 2011 e Google Penguin nel 2012, quest’ultimo particolarmente rilevante poiché riguarda i link in ingresso di un sito. Essi hanno arginato alcuni fenomeni come la produzione di contenuti di scarso valore o la partecipazione a schemi di link al fine di manipolare il PageRank, penalizzando diversi siti nei risultati di ricerca.

Il 22 maggio 2013 è stato rilasciato l’aggiornamento Penguin 2.0, un ulteriore sviluppo di Penguin, reso maggiormente sofisticato. Nel video seguente, apparso il 13 maggio del 2013 (pochi giorni prima del rilascio di Penguin 2.0).

![]() Un bel compendio aggiornato a marzo 2019 degli algoritmi di Google

Un bel compendio aggiornato a marzo 2019 degli algoritmi di Google

E poi per approfondire puoi leggere questo articolo su Google Panda, questo su come fare seo dopo google penguin e quest’altro su Google Hummingbird.

4b – SEO: FATTORI DI RANKING

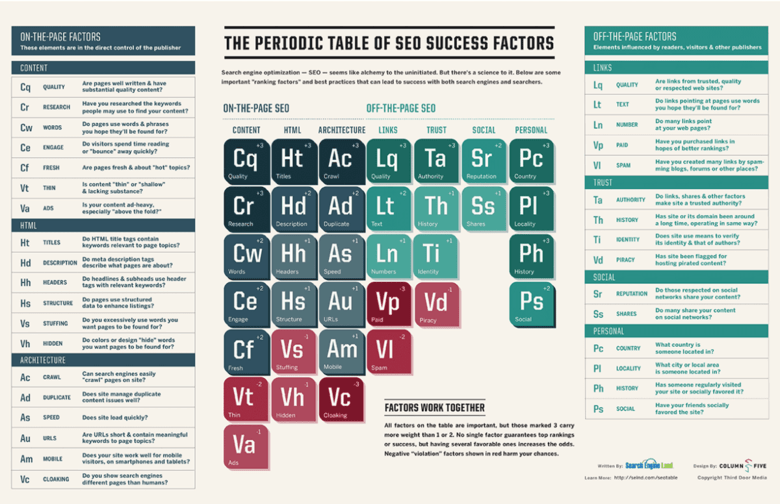

I fattori di ranking sono gli elementi che influenzano in modo determinante il posizionamento di un sito web nei risultati dei motori di ricerca.

Sono un insieme di parametri che attraverso all’algoritmo di calcolo definiscono quale sia la pagina web più rispondente alla ricerca effettuata dall’utente sul motore di ricerca.

I fattori di ranking sono circa 200, e ognuno di loro ha una sua specifica influenza all’interno dell’algoritmo di calcolo che determina il posizionamento di un sito web nelle SERP di Google.

![]() Ecco una guida esaustiva: https://www.seozoom.it/la-guida-ai-200-fattori-di-ranking-su-google/

Ecco una guida esaustiva: https://www.seozoom.it/la-guida-ai-200-fattori-di-ranking-su-google/

![]() e una riassuntiva https://it.semrush.com/blog/fattori-seo-ranking-piu-importanti-per-il-posizionamento-su-google/

e una riassuntiva https://it.semrush.com/blog/fattori-seo-ranking-piu-importanti-per-il-posizionamento-su-google/

Alcuni fattori di ranking principali:

Fattori di ranking del dominio

Per alcuni fattori riguardanti il dominio, ci sono delle discrepanze tra le dichiarazioni ufficiali di Google e le sperimentazioni degli esperti SEO, non è quindi ben chiaro cosa influenza la SEO e cosa no, ecco alcuni di questi fattori.

- Anzianità del dominio: Google ha ufficialmente detto che non è un fattore di ranking, tuttavia, se un dominio ha uno storico, è molto più semplice determinarne l’autorevolezza, che è appunto un fattore di posizionamento.

- Query presente nel nome del dominio: potrebbe aiutare l’algoritmo di Google a capire l’argomento trattato nella pagina, ma, ufficialmente, è una pratica che viene scoraggiata da Google stessa, dopo l’introduzione dell’algoritmo EMD (Exact Match Domain).

- Estensione del dominio: non è ufficialmente un fattore di ranking di Google, però può aiutare il posizionamento della pagina, perché comunica a Google il paese da cui essa proviene.

- Autorità del dominio: è l’autorità di un sito web rispetto all’argomento trattato al suo interno. Un sito è autorevole quando ha contenuti di qualità, punta a risorse esterne pertinenti e autorevoli a loro volta, cercando di ricevere altrettanti collegamenti in ingresso.

Fattori on site

L’ottimizzazione SEO on page riguarda molti aspetti, alcuni dei quali non sono veri e propri fattori ranking utilizzati da Google ma buone pratiche SEO, ecco quali sono.

- Lo sviluppo di un’architettura del sito logica e fluida

- Aggiornamenti tecnici del sito costanti

- URL leggibili e ottimizzati

- Utilizzo delle Sitemap (mappa dei contenuti, mappa dei video, mappa delle immagini, mappa degli autori)

- Utilizzo del file Robots

- Utilizzo dei meta tag influenti per il posizionamento SEO come tag title, meta description, heading, meta open graph e meta tag specifici (non influenti) come, ad esempio, quelli per le PWA e per specifici dispositivi o sistemi operativi

- Internal Linking

- External Linking (nofollow, ugc, sponsored, noopener, noreferrer)

- Certificato SSL

- Presenza di pagine Termini e Privacy

- Presenza dei Breadcrumb

- Ottimizzazione Mobile

- Usabilità del sito

- Utilizzo di Analytics e Search console

- Utilizzo dei Dati Strutturati – Microdati

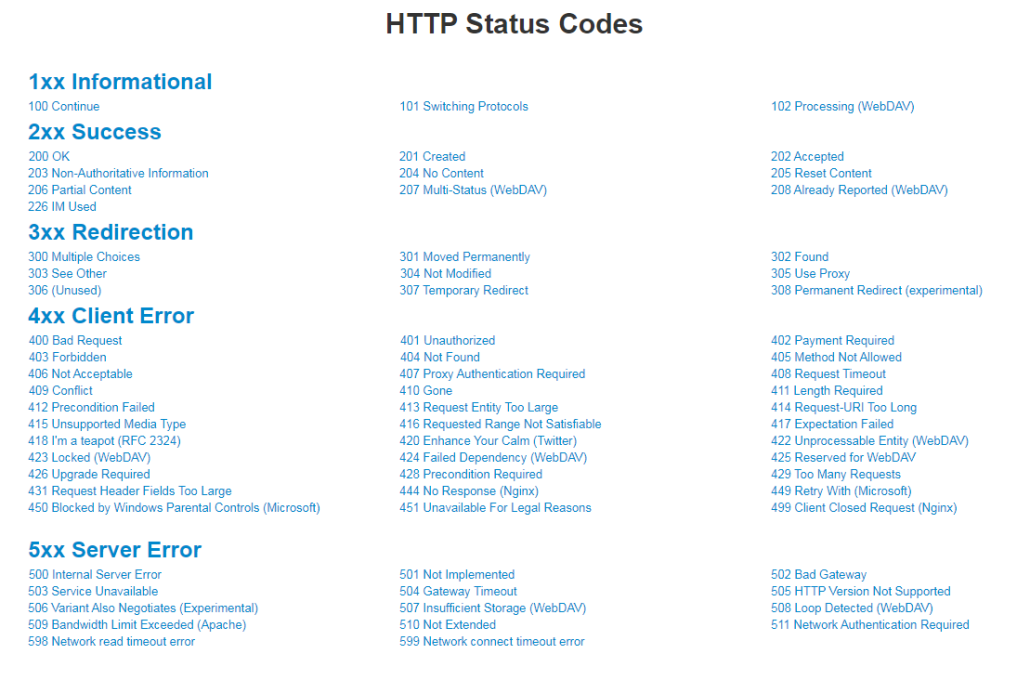

- Correzione degli errori tecnici come le pagine 404

A livello di contenuti:

- Il tag title: è il titolo delle pagine web che appaiono nelle SERP, deve contenere la focus keyword e deve stare nei 70 caratteri per essere completamente visibile all’utente.

- Il tag meta description: è il testo che appare sotto il title, non influenza in modo diretto l’algoritmo di ranking ma se accattivante e se contiene la focus keyword, contribuisce ad aumentare il CTR (Click Through Rate) della pagina.

- Keyword prominence: la parola chiave deve trovarsi all’inizio in una determinata porzione di pagina e negli elementi più importanti della pagina, title, heading tag, alt tag e nomi file delle immagini, URL della pagina, meta description.

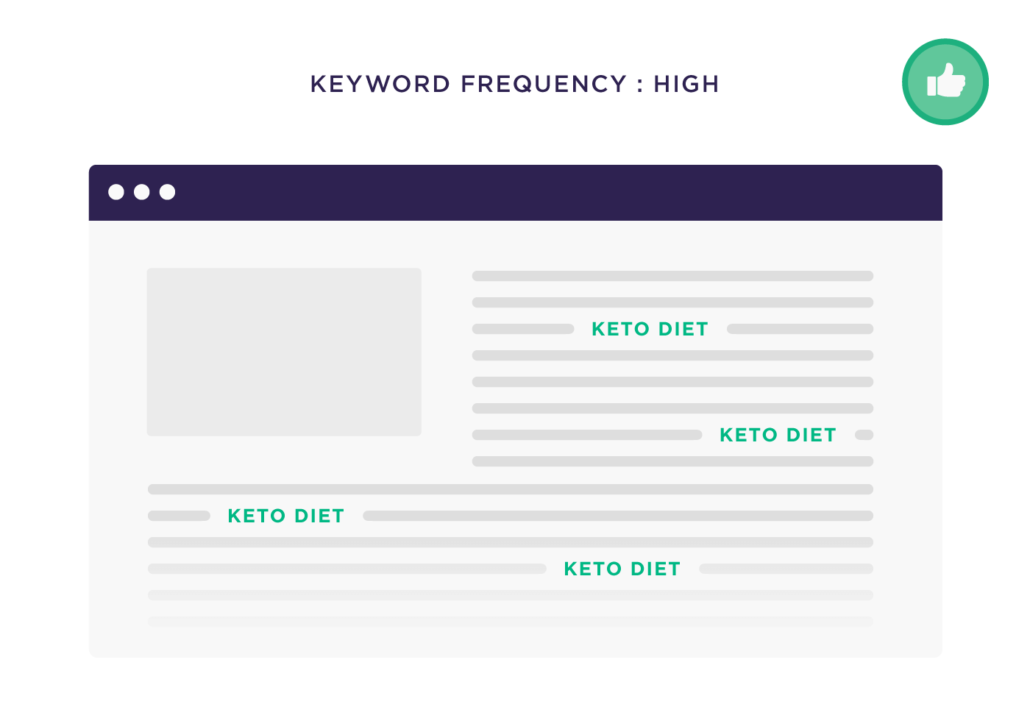

- Keyword density e keyword frequency: La Keyword density è la concentrazione in percentuale della parola chiave in una pagina in relazione al numero totale di parole, questa non deve essere troppo alta in quanto potrebbe essere interpretata dal motore di ricerca come una forzatura e causare penalizzazioni. La Keyword Frequency è un valore assoluto che indica il numero di occorrenze della parola chiave, anche in questo caso non bisogna esagerare nella ripetizione della parola chiave per evitare il Keyword Stuffing.

- Keyword proximity: è la vicinanza delle parole chiave che compongono la frase chiave ed è un valore che ha a che fare con le eventuali query di ricerca effettuate dall’utente.

- Ottimizzazione delle immagini: i tag title e alt e il nome file delle immagini devono contenere la focus keyword o le sue correlate.

- I tag di heading: il tag H1 deve contenere la focus keyword, i tag H2 e H3 la focus keyword o le correlate.

- L’URL della pagina: deve essere breve e chiaro, seguendo la struttura dominio/focus keyword.

- Presenza della Table of contents: una pagina con indice dei contenuti facilita l’utente nella navigazione, ma soprattutto serve al motore di ricerca per analizzare meglio i contenuti presenti in pagina.

- Link in uscita: come anticipato nel paragrafo precedente, puntare a risorse esterne pertinenti e autorevoli aumenta l’autorità del dominio, aiutando il posizionamento.

- Ottimizzazione mobile: ormai la maggior parte del traffico internet arriva dai dispositivi mobile. Non importa se riprogettata da zero o adattata da una versione desktop, ogni pagina web deve funzionare bene anche su dispositivi mobile.

Fattori SEO off site

Sono fattori di ranking indiretto che dipendono da quello che c’è all’esterno della pagina web. I backlink sono il fattore di ranking più importante per Google!

In linea di massima:

- Il numero di Link

- La qualità dei Link

- Attributi No Follow / Do Follow

- L’anchor-text

- La pertinenza;

- La qualità e l’attinenza della Landing Page.

- e poi i backlink, sono uno dei fattori SEO più importanti. Una pagina web ha un backlink quando un’altra pagina esterna si collega ad essa tramite un link. Questo link può essere un testo, chiamato anchor text, o può essere un oggetto cliccabile, come un’immagine o un bottone. Google considera come fattore di ranking il numero dei domini e delle pagine che linkano, l’autorevolezza del dominio e della pagina da cui proviene il link, gli anchor text dei backlink, l’attributo title del link, i link alla homepage, link da siti con indirizzo IP e C-Classi diversi e altri ancora. Ricevere un link in entrata non è sempre un beneficio. Il link entrante può essere innaturale e forzato, non mostrando un reale interesse o pertinenza rispetto alla pagina ricevente, ma fatto solo per manipolare l’algoritmo di Google. In questi casi viene penalizzato sia chi manda il link sia chi lo riceve, per questo, prima di pubblicare una pagina, è bene analizzare tutti i backlink tramite appositi strumenti, ed eliminare i link ritenuti nocivi. Per disconoscere i link entranti tossici, Google mette a disposizione il suo Disavow Tool, che è parte di Google Search Console.

- Link reciproci: è necessario evitare link reciproci con altri siti, Google potrebbe penalizzare questa pratica perché i link devono essere naturali.

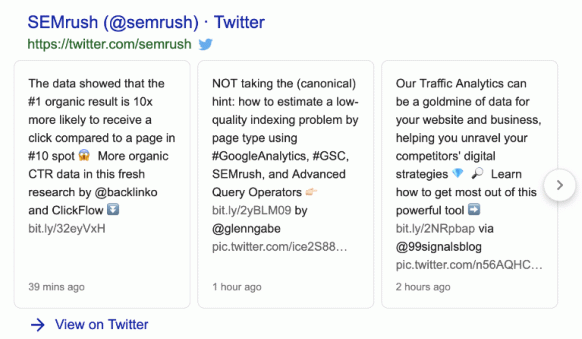

- Segnali social: Se una pagina web è popolare sui social, maggiori sono le possibilità che venga condivisa, generando, quindi, dei backlink naturali alla pagina. Dunque, sebbene i segnali social non siano un fattore di ranking ufficiale, hanno comunque effetti positivi su un sito

- Eventuali informazioni su Google My Business, il servizio di Google per la localizzazione delle attività

La User eXperience come fattore di ranking

Da quando Google ha introdotto l’algoritmo RankBrain per l’analisi delle pagine, la User eXperience (UX) è diventata un fattore di ranking. La UX rappresenta il grado di soddisfazione dell’utente dopo che ha visitato una pagina web. Esistono delle metriche molto precise che misurano l’esperienza dell’utente e che Google valuta come fattori di ranking. Ecco quali sono.

- Tempo di permanenza: è il tempo medio di permanenza dell’utente su una pagina. Un valore di pochissimi secondi indica un problema, per esempio, una pagina scomoda da consultare o che non risponde all’intento di ricerca dell’utente. Al contrario, un valore molto alto, indica una pagina pertinente, piacevole ed esaustiva.

- Il CTR: è il rapporto tra il numero di click sulla pagina e le sue impressions (il conteggio delle volte che la pagina appare in una SERP). Se il CTR è alto, è probabile che il solo rich snippet abbia incuriosito l’utente e risposto alla sua domanda.

- Frequenza di rimbalzo: indica quante volte l’utente ha cliccato sulla pagina nella SERP ma poi ha smesso di interagire con la pagina stessa. Se il valore è alto, può indicare un problema sulla pagina.

- Pogo Sticking: misura un evento molto preciso, cioè quando l’utente clicca su un risultato nella SERP, torna subito indietro e clicca su un’altra pagina, sempre in quella SERP. Indica che l’utente è rimasto insoddisfatto della prima pagina ed è tornato indietro per cliccarne un’altra.

6 – SEO ONPAGE: PAROLE CHIAVE

L’attività SEO nel dettaglio

L’attività SEO comprende diverse fasi di tipo sia analitico/strategico che operativo. Sul piano operativo, per ottimizzare un sito occorre tenere in considerazione molti fattori diversi. Un approccio originale per descrivere i principali tra questi fattori è stato realizzato da Search Engine Land, una nota ed autorevole rivista americana del settore. Search Engine Land ha realizzato una tavola periodica dei fattori di ranking (che aggiorna periodicamente man mano che Google aggiorna il suo algoritmo).

La fase strategica SEO: la scelta delle keywords

Questa fase è fondamentale, qualunque attività SEO risulta essere priva di senso se non viene effettuata prima un’analisi accurata delle parole chiave da scegliere per la propria campagna. La ricerca delle parole chiave “migliori” può essere effettuata con strumenti software appositi, interviste agli utenti, analisi della concorrenza (benchmarking competitivo) e utilizzando lo stesso motore di ricerca.

La ricerca di parole chiave per la SEO consiste nella raccolta di tutte le possibili varianti di parole chiave che potrebbero essere rilevanti per il tuo sito, il tuo contenuto, i tuoi prodotti, servizi (ecc.) e/o per i tuoi clienti o utenti ideali, anche se non direttamente correlate con ciò che offri.

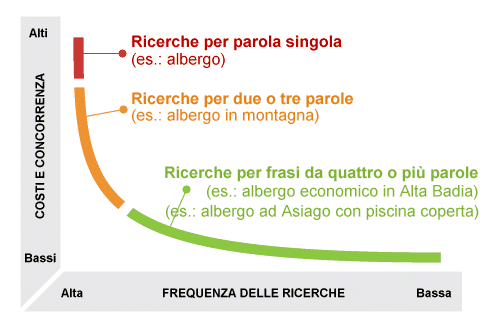

Per il successo di una campagna SEO è consigliabile selezionare parole chiave non troppo generiche, poiché risulterebbe molto difficile o addirittura impossibile raggiungere buoni risultati in tempi utili, ma neppure troppo specifiche, poiché, se sono poco cercate, generano di conseguenza poco o nessun traffico al sito.

Le parole chiave rientrano in due categorie:

- Head Terms – Parole chiave brevi con un volume di ricerca maggiore ma alta concorrenza, come web marketing, auto sportive o immobiliare. Queste si rivolgono a un pubblico vasto e sono, di solito, più difficili da classificare.

- Long Tail – Si tratta di termini di ricerca più descrittivi e formati da più parole, quali corso di web marketing serale torino, porsche carrera usata milano, affitto zona parella torino. Queste sono rivolte a query di ricerca più specifiche e hanno minore concorrenza e volume di ricerca più basso.

Nella scelta delle keyword è applicabile la teoria della “Long Tail” di C. Anderson, secondo la quale i prodotti di nicchia avranno molte più possibilità di profitto. Per applicare questa teoria in ottica seo, è quindi preferibile scegliere molte parole chiave specifiche (con meno concorrenza e tasso di conversione maggiore) piuttosto che poche generiche (con molta concorrenza e basso tasso di conversione).

Per approfondire con studio samo: coda lunga e posizionamento nei motori di ricerca:

un esempio di strategia SEO “coda lunga”

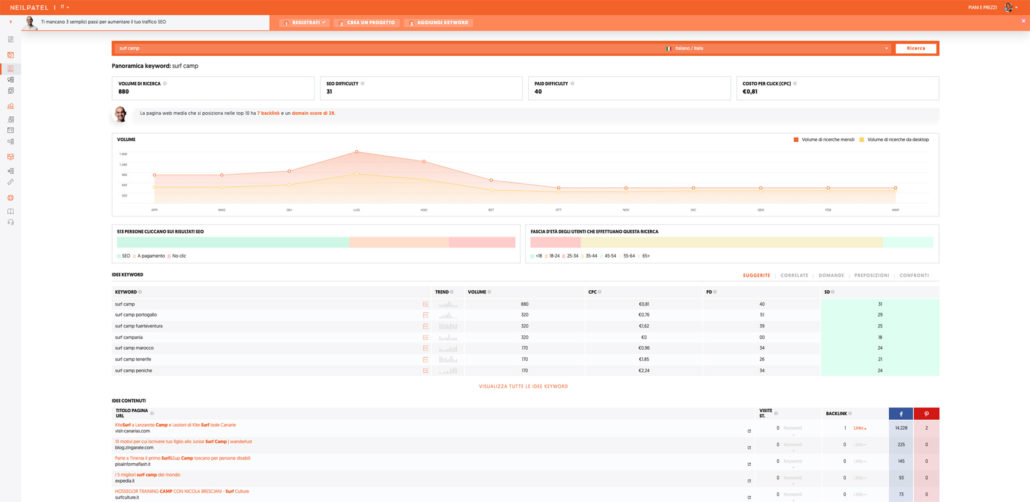

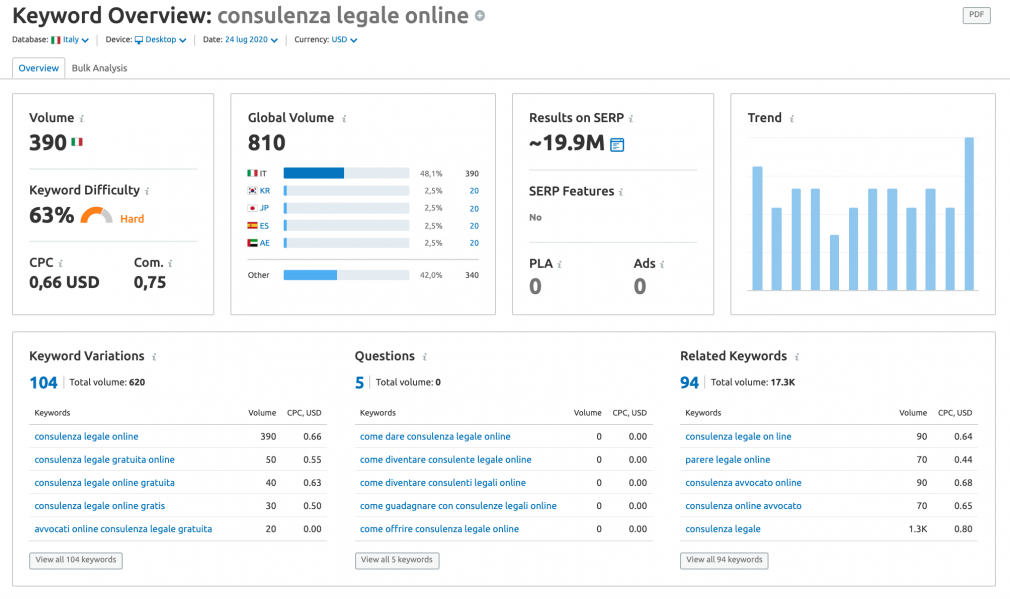

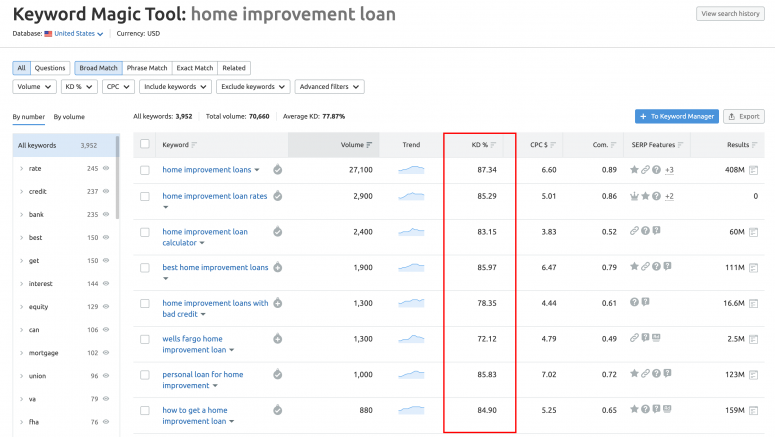

Gli strumenti per la key research e i parametri

Quali parole vengono usate per cercare alcuni argomenti? Quanta concorrenza e che volume di ricerca hanno?Ci sono diversi strumenti che aiutano in questo lavoro:

->strumento per le parole chiave di Google AdWords. Questo strumento offre dati statistici sul numero di ricerche mensili, globali o per singolo Paese, che vengono effettuate dagli utenti con una determinata chiave di ricerca. Accedi all’interfaccia principale di Google Ads > Strumenti e impostazioni > Strumenti di pianificazione delle parole chiave > Individua nuove parole chiave > inserisci le tue parole chiave (una o più) > Ottieni i risultati.

->Ubersuggest by Neil Patel, uno strumento in parte gratuito che suggerisce le parole chiave per un dato argomento e che permette di ricercare le parole più utilizzate per un certo dominio (e quanto stanno effettivamente performando). Consente di spiare i backlink della concorrenza, vedere per quali keyword si stanno posizionando e fare una ricerca decente delle parole chiave. Se si fa SEO senza un grosso budget, è perfetto

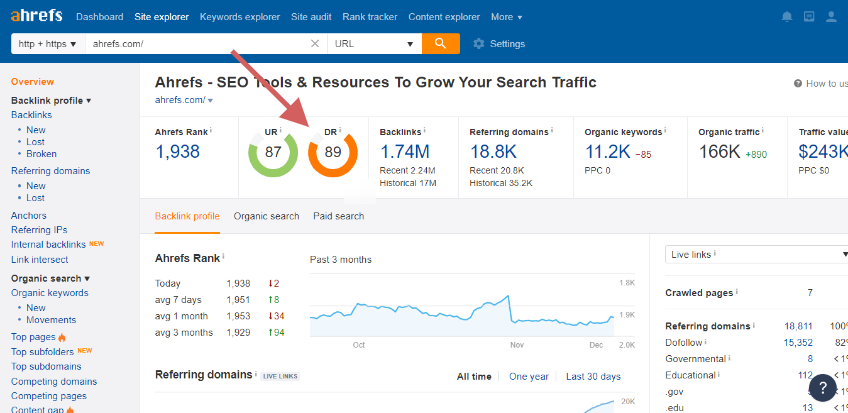

->SEOZOOM, SEMRUSH, AHREFS (ecc..):

strumenti a pagamento (ma con demo online da provare) che offrono tutti gli strumenti più utili per un’analisi seo e una pianificazione di progetti di web marketing a 360°

Keyword tool di Semrush, ti fornirà informazioni piuttosto dettagliate sui dati relativi a una singola parola chiave, così come collegamenti a parole chiave con “corrispondenza a frase” e “correlate”.

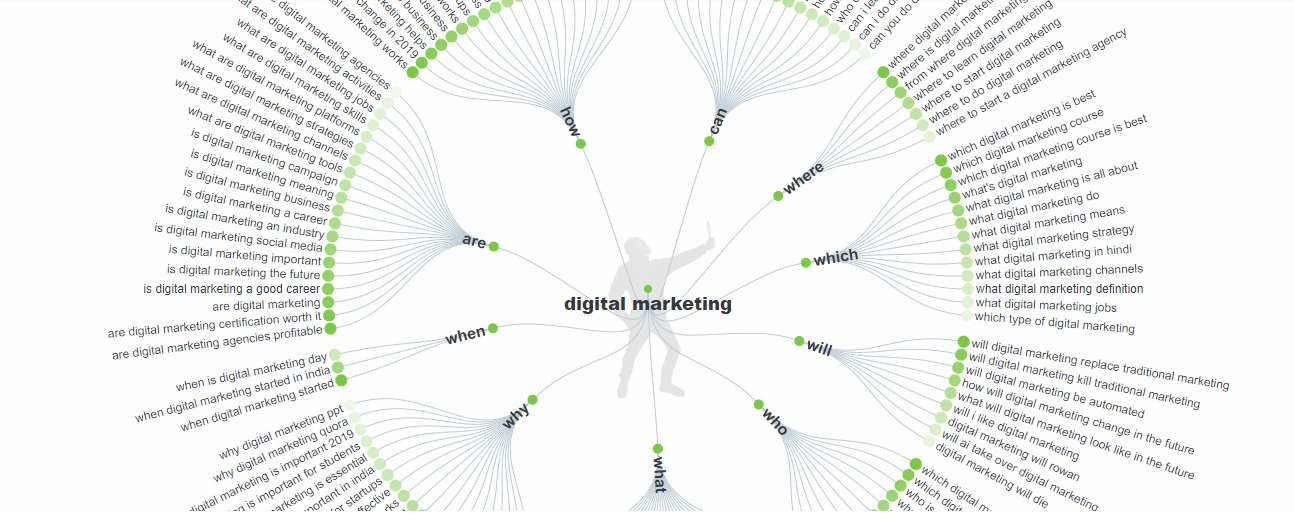

Answer The Public è una risorsa che consente di generare tipi di domande e frasi richieste per una particolare parola chiave. Inserendo una parola chiave, vengono restituite delle schermate con tutte le domande correlate a quella keyword, anche se la schermata “Dati” e le opzioni di download in formato CSV risultano ancora più utili.

Il primo passo da compiere nella ricerca delle parole chiave per la SEO consiste nel raccogliere l’elenco più ampio possibile di parole chiave iniziali utilizzando ad esempio i tool di cui sopra o anche un bel foglio bianco e poi segnarseli

-> Keywords Everywhere APP per browser

è un’estensione browser per Chrome o Firefox in grado di restituire in tempo reale volume di ricerca, CPC e dati relativi alla concorrenza ogni volta che si digita una ricerca online!

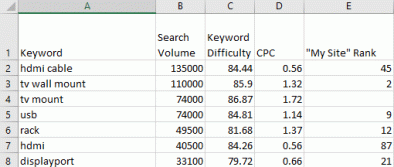

I parametri più importanti per ogni keyword da rilevare sono:

- La parola chiave stessa

- Il volume di ricerche mensile

- La keyword difficulty (concorrenza)

- Il costo per clic (CPC), dipendente dalle inserzioni

- Il posizionamento attuale / domain autohority

Key Difficulty?

La difficoltà di una parola chiave si basa su diversi parametri, considera la concorrenza e NON ha un valore assoluto.

La Key difficulty in alcuni tools (semrush e hrefs) si basa sul numero di domini collegati ai risultati migliori.

Per capire la difficoltà di una parola chiave si può guardare la domain authority delle pagine principali.

Es: se una parola chiave ha un punteggio di difficoltà di 8, ma le prime pagine posizionate hanno tutte un domain ranking superiore a 80 (quindi con un alto domain authority), posizionare il vostro sito per quelle parole chiave potrà essere difficile se il vostro sito ha un domain ranking basso (come dire: c’è un’alta concorrenza non sulla parola chiave sul posizionamento in base all’autorità alta degli altri domini concorrenti).

Meglio quindi mirare a parole chiave con una keyword difficulty abbastanza bassa se avete un domain ranking basso, quindi allargarvi costruendo più collegamenti e ottenendo un’autorità più elevata. Man mano che il domain ranking fa la sua scalata, i vostri link interni acquisteranno più influenza.

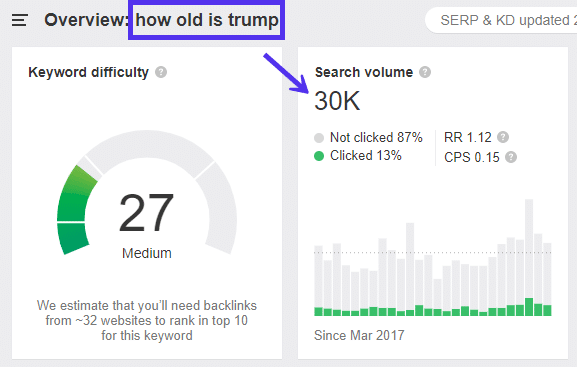

Il Volume di ricerca è importante?

Solo perché 10.000 persone cercano una parola chiave (al mese) non significa che tutte le 10.000 persone faranno effettivamente clic su un risultato. Se si guarda la a parola chiave “Quanti anni ha Trump”, ad esempio: ottiene 30.000 ricerche al mese, ma solo il 13% di quelle persone fa effettivamente clic su un sito. Questo perché le persone ottengono la risposta direttamente su Google e non è necessario fare clic per trovarla (ad esempio). Ma possono essere altri i motivi per cui una parola con un alto volume di ricerca.

(es. dal sito: https://kinsta.com/it/blog/keyword-research/)

Questa metrica non include le long-tail keyword e le LSI (Indicizzazione Semantica Latente), cioè non propriamente dei sinonimi ma delle parole chiave che servono a conferire un significato alla parole chiave che indicizza (es. Auto parola chiave che può voler dire più cose con l’aggiunta di veicolo LSI).

Ad esempio può capitare che la keyword principale conto 1000 ricerche al mese ma l’articolo ottiene oltre 3.000 visite al mese. Questo perché la parola chiave si sta posizionando per altre parole chiave oltre alla keyword principale!

Ecco perché nei contenuti è buona cosa includere in modo naturale parole chiave LSI.

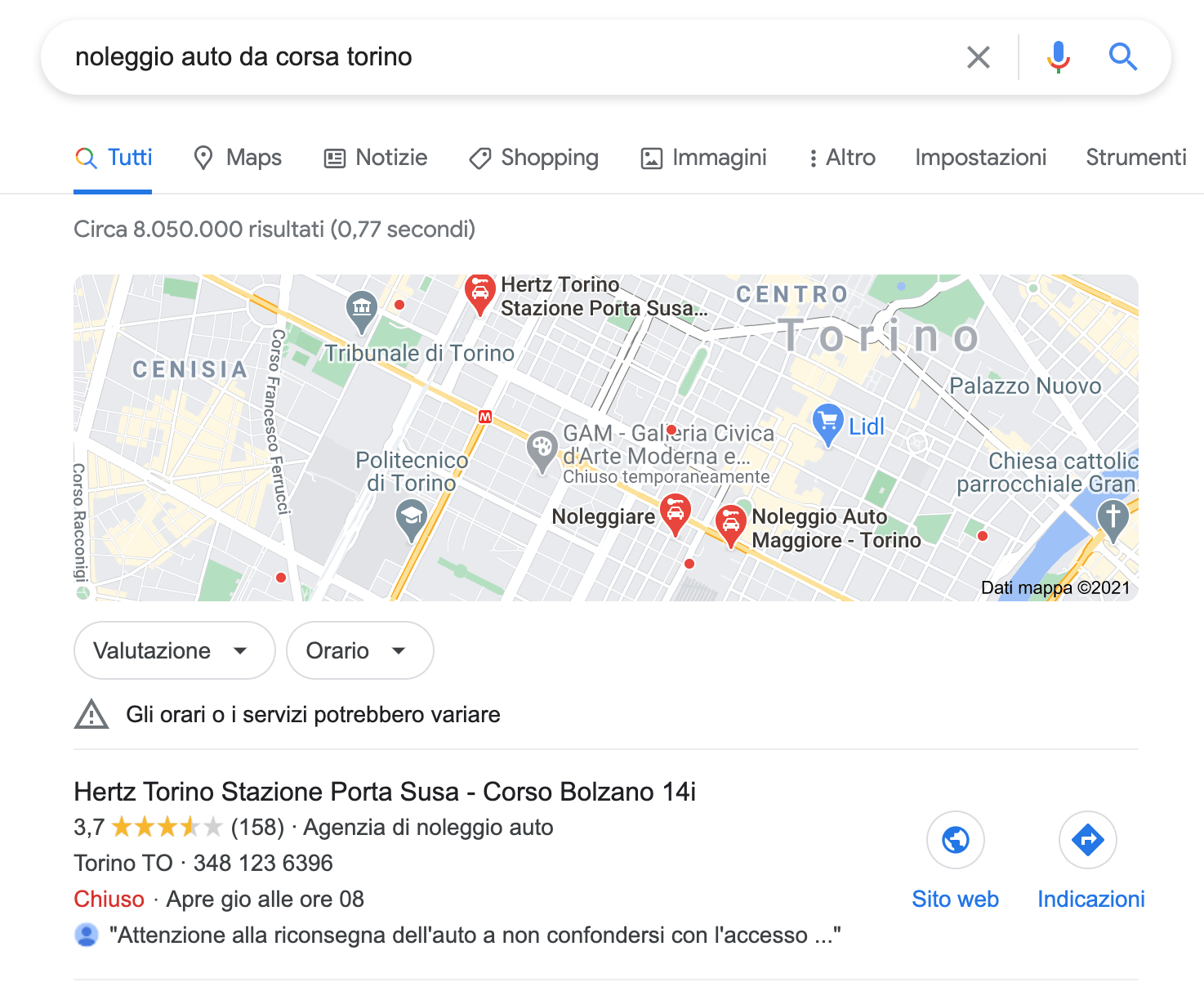

L’intento di ricerca

Anche dopo aver trovato buone idee per le parole chiave, dovreste sempre cercarle manualmente su Google e vedere cosa si sta attualmente posizionando per avere un’idea del contenuto che dovete creare. Non scrivete una guida interminabile se le persone vogliono solo una risposta rapida, e non cercate di posizionare un articolo del blog quando le persone stanno cercando di acquistare un prodotto.

Le parole chiave vengono di norma raggruppate in:

- Parole chiave transazionali: quando un utente esegue una ricerca per concludere immediatamente una transazione o una conversione.

- Parole chiave navigazionali: usate per trovare una specifica marca o sito.

- Parole chiave informative: correlate a informazioni generali su un argomento.

Ad esempio:

Una parola chiave che suggerisce un intento di acquisto elevato può essere un nome di prodotto, ad esempio Noleggio auto da corsa Torino. Se lo digitate in Google e guardate i risultati, vedrete un sacco di annunci per noleggi auto e una mappa che mostra le compagnie di noleggio auto a Torino. Se una persona sta facendo questa ricerca, è probabilmente pronta per l’acquisto o è molto vicina a farlo.

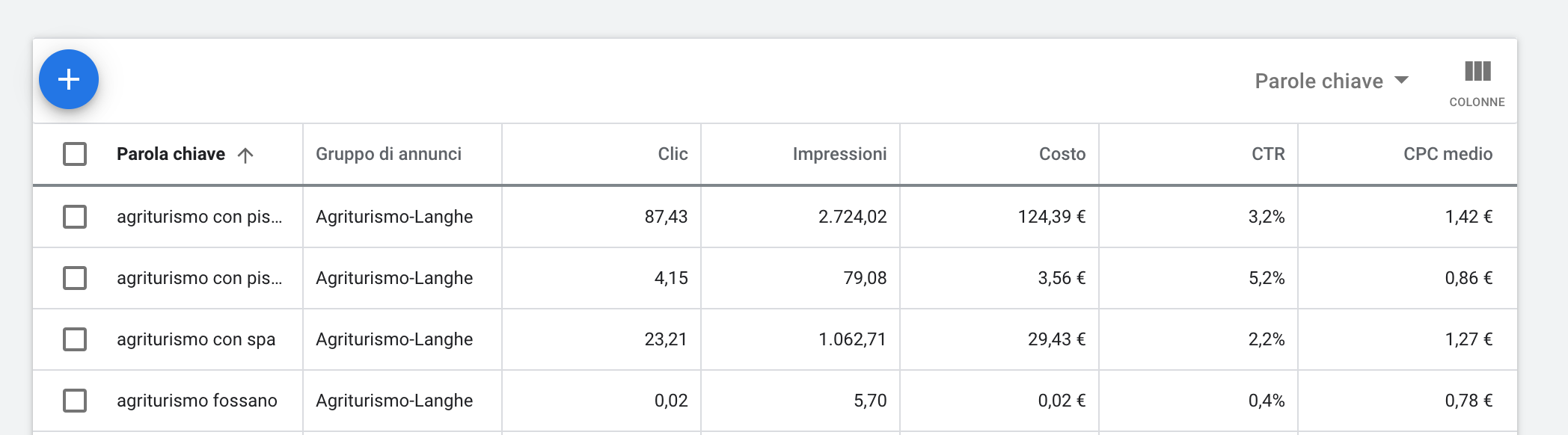

Valuta anche il CPC (costo per click) anche per la ricerca organica

Sebbene il costo per click sia una metrica PPC può anche indicare l’importanza relativa delle parole chiave organiche perché maggiore sarà l’offerta su un termine, tanto maggiore sarà la probabilità che esso porti a una conversione.

Parametri keywords sul Google Ads

Migliora il domain authority

La Domain Authority (DA) è una metrica numerica che indica l’autorità di un dominio, dove maggiore è il suo valore maggiori dovrebbero essere le possibilità di posizionarsi più in alto nei risultati dei motori di ricerca (SERPs) e ottenere quindi più traffico organico (almeno questo è l’obiettivo di chi l’ha ideata).

La metrica è stata sviluppata da Moz, ma altre società hanno creato metriche simili che classificano i domini in base ad una serie di fattori ed assegnano loro una valutazione da 0 a 100 e si basa su 40 fattori.

L’idea di classificare i domini in base alla loro autorità, si basa sull’emulazione di un sistema simile al PageRank (che si basa su molti più fattori).

- il numero di link in entrata che puntano al tuo sito;

- la qualità e la pertinenza dei link in entrata (dipendono dal rank del sito che linka sul tuo);

- la qualità del contenuto presente nelle pagine del tuo sito;

- i segnali sociali intesi come popolarità del tuo dominio sui social media;

- le prestazioni SEO del tuo sito in generale.

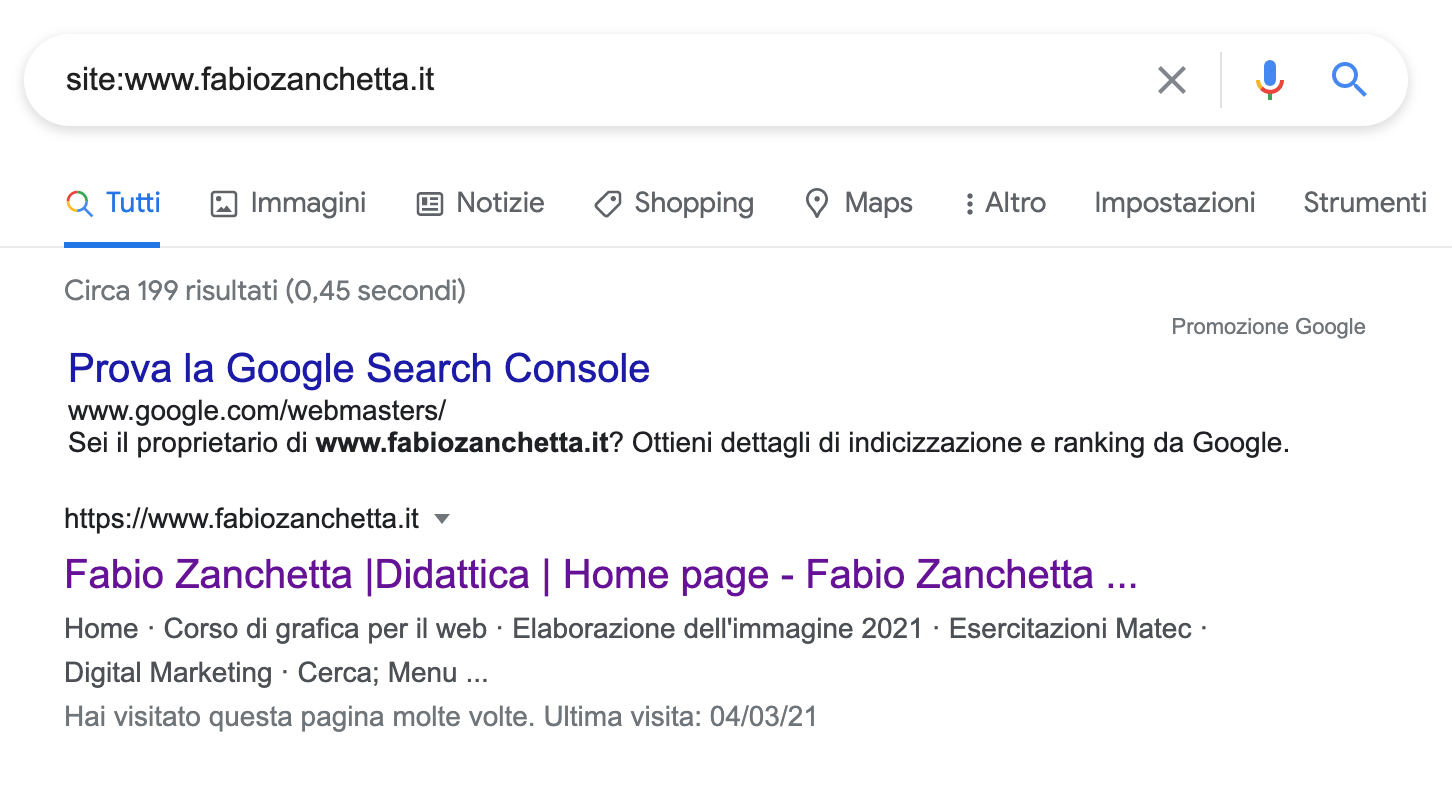

Come verificare la DA del sito web?

Per scoprire la Domain Authority del tuo sito:

- vai all’indirizzo https://moz.com/link-explorer; (ma anche semrush, ahrefs e seozoom ne hanno implementato uno)

- registra un account free o di prova;

- digita il nome del tuo dominio e guarda il risultato.

Il Domain Autohority/Rating non ha alcun effetto diretto sul posizionamento di una pagina su Google ma è una metrica che serve a dare un’idea di come e quanto Google vede autorevole il sito.

Una volta trovate le parole chiave per una certa pagina (o per il sito intero) dove aggiungerle?

I motori di ricerca esaminano le posizioni in cui appaiono le parole chiave sul tuo sito e assegnano priorità ad alcune aree rispetto ad altre. Ecco alcune posizioni ideali in cui aggiungere le parole chiave, in ordine di importanza:

- Dominio del sito

- Titolo Sito

- Slug URL della pagina

- Titolo SEO e titolo della pagina

- Descrizioni SEO di sito, pagina ed elemento

- Intestazioni (ad es., Intestazione 1, Intestazione 2, Intestazione 3)

- Il corpo del testo

- Categorie

- Didascalie e titoli per Blocchi immagine, Blocchi galleria, Pagine galleria e sezioni della Galleria

- Nomi di file per file e immagini

- Testo alternativo

![]() La strategia di keyword research passo passo.

La strategia di keyword research passo passo.

![]() Trovare le parole chiave più coerenti ed efficaci, la guida più esauriente

Trovare le parole chiave più coerenti ed efficaci, la guida più esauriente

![]() Analisi delle parole chiave della concorrenza e come trovare backlink

Analisi delle parole chiave della concorrenza e come trovare backlink

6b – Ottimizzazione dei contenuti e SEO Copywriting

I contenuti sono in verità la parte più importante della SEO, infatti i motori di ricerca evoluti, come Google, riescono a leggere i contenuti testuali di un documento, “capendone il significato” ed attribuendone un punteggio di qualità e pertinenza rispetto alle query. L’importanza dell’attività di creazione di contenuti di qualità è esemplificata dal noto mantra della SEO “Content si King“, il contenuto è Re (frase attribuita a Bill Gates).

E’ opportuno quindi che un sito contenga realmente contenuti utili e interessanti che creino un valore per gli utenti al fine di ottenere un buon posizionamento sui motori di ricerca. Un sito povero di contenuti non potrà essere ben posizionato, o comunque sarà difficile mantenere la posizione nel lungo periodo.

Un chiaro esempio e Wikipedia, che risulta tra i primi risultati per un gran numero di chiavi di ricerca. Per garantire la presenza di contenuti di qualità sul proprio sito, è bene anche aggiornarlo aggiungendo nuovi testi con una certa frequenza. Per questo motivo, aprire un blog aziendale integrato nel proprio sito è il miglior modo per ottenere un buon posizionamento duraturo nel tempo.

E’ di importanza fondamentale, oltre ad avere buoni contenuti, avere contenuti unici, quindi non copiati da altri siti. Google si accorge quando un contenuto non è originale e lo penalizza drasticamente nei suoi risultati.

Naturalmente, il contenuto dovrà includere le parole chiave con cui si vuole essere trovati, ma in maniera tale da non risultare innaturale per il visitatore. Google e gli altri motori di ricerca moderni utilizzano sistemi di analisi semantica del testo che comprendono la sinonimia e la correlazione tra termini.

Data questa evoluzione, possiamo facilmente comprendere come l’eccessiva ripetizione della parola chiave presa di mira (in gergo keyword stuffing) in un testo – come facevano i SEO diversi anni fa, quando gli algoritmi erano meno evoluti – non produce alcun miglioramento nel posizionamento (si rischia anzi di svalutare l’esperienza degli utenti ed ottenere l’effetto contrario). E’ invece opportuno scrivere in maniera naturale, con l’obiettivo di produrre contenuti interessanti per gli utenti, non per i robot.

L’attività di scrivere contenuti SEO è detta SEO Copywriting, ed è l’arte di combinare la buona scrittura con gli elementi dell’ottimizzazione.

Parlando di contenuti e snippet..?

Dove sono localizzati i contenuti importanti per il SEO?

-

-

-

- Tag title: il titolo della pagina è un elemento fondamentale da inserire nella sezione head del documento. La lunghezza del titolo deve essere compreso tra i 40 e i 70 caratteri che rappresentano la dimensione massima per essere visualizzato nelle SERP di Google (che in realtà però si misura in pixel, motivo per cui se il TITLE è in maiuscolo lo spazio occupato sarà maggiore..quindi meno caratteri!).

-

-

-

-

-

- Meta tag description: la descrizione della pagina è un fattore che Google non considera più ai fini del posizionamento. È però utile scrivere una description che contenga la keyword e che invogli l’utente a cliccarci in quanto comparirà nelle SERP dei risultati organici di ricerca. Anche in questo caso la lunghezza massima è di 156 caratteri. Includi nella descrizione informazioni codificate in modo chiaro. Non è necessario che la meta descrizione contenga solo una frase, perché rappresenta anche il punto ideale per inserire informazioni sulla pagina. Ad esempio, notizie o post su blog possono indicare l’autore, la data di pubblicazione e informazioni sulle fonti. In tal modo, i potenziali visitatori otterranno informazioni molto pertinenti che altrimenti non potrebbero essere visualizzate nello snippet. Analogamente, nelle pagine dei prodotti, le informazioni chiave (prezzo, età, produttore) possono essere distribuite in tutta la pagina. Una meta descrizione accurata raggruppa tutti questi dati. Ad esempio, la seguente meta descrizione fornisce informazioni dettagliate su un libro. Ricordati che da mobile la lunghezza dello snippet è minore e varia anche in base al dispositivo (circa 120 caratteri).

-

-

-

-

-

- Tag ALT: è il testo alternativo delle immagini. Ogni pagina o post di un blog deve contenere almeno un’immagine. Es.

- Tag ALT: è il testo alternativo delle immagini. Ogni pagina o post di un blog deve contenere almeno un’immagine. Es.

-

-

-

-

-

- Url: la parola chiave che abbiamo scelto deve sempre essere presente nell’indirizzo della pagina. Per questo motivo è utile gestire ed impostare correttamente i permalink in modo da risultare leggibili.Deve esssere max 7 o 8 parole, meno di 100 caratteri

- unico

- parlante

- di lunghezza limitata

- privo di stop-words

- Esempio: www.tuttoseo.it/corso-seo-avanzato-6-errori-meta-description-da-evitare

- Url: la parola chiave che abbiamo scelto deve sempre essere presente nell’indirizzo della pagina. Per questo motivo è utile gestire ed impostare correttamente i permalink in modo da risultare leggibili.Deve esssere max 7 o 8 parole, meno di 100 caratteri

-

-

-

-

-

- Tag Headings: rappresentano i tag per la formattazione del testo in paragrafi e sotto-paragrafi. È consigliabile utilizzare un solo h1. La gestione e l’inserimento dei paragrafi dipende molto dalla struttura del layout.

-

-

Prova il tool snippet preview: Seomofo

![]() Per approfondire leggi questo articolo sul seo copywriting e questo sui contenuti duplicati.

Per approfondire leggi questo articolo sul seo copywriting e questo sui contenuti duplicati.

KEYWORDS e ONPAGE SEO, alcuni consigli:

![]() La guida definitiva dell’onpage SEO del 2020 (english)

La guida definitiva dell’onpage SEO del 2020 (english)

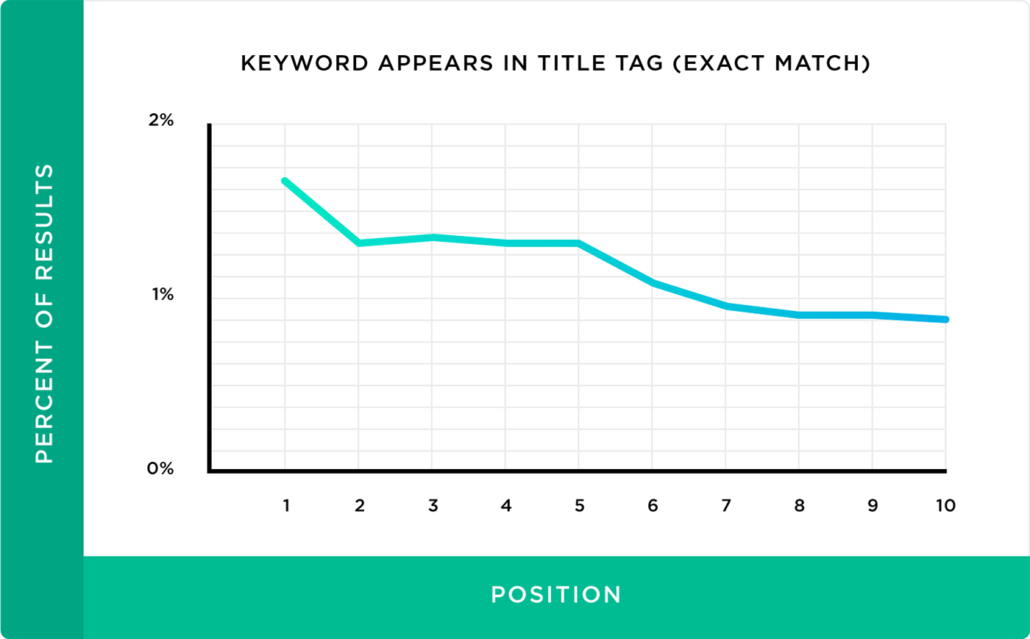

1 – Da un’analisi di 1 milione di di ricerche su Google è risultata una correlazione netta fra la parole chiave nel tag title e la prima pagina della serp

2 – Se cerchi una parola competitiva (vedere Key Difficulty in tool quali SeoZoom, SemRush, NeilPatel Ubersuggest), noterai che nel top del ranking quasi tutte le pagine usano quella stessa parola chiave nel tag Title e nella meta description.

3 – Usa la tua parola chiave per cui vuoi essere trovato nelle prime 100-150 parole.

4 – Detto più volte: aiuta Google a spiegare di cosa parla la tua pagina con il tag H1, usando parole chiave che si correlano a quelle del Tag Title.

Title e H1 simili ma non identici (almeno stando ai consigli di Google)

Title:

Google SEO: Should Titles & H1 Tags Be Identical?

H1:

Google SEO: Should Titles & H1 Tags Be Exactly The Same?

5 – Ragiona sulla Keyword Frequency. Google non da indicazioni chiare in merito ma gli esperti sostengono che un numero minimo di volte – fra le 5 e le 10 – la keyword principale dovrebbe essere ripetuta.

6 – Usa link esterni, soprattutto verso link certificati e autorevoli, Google apprezzerà.

7 – Usa url SEO FRIENDLY. Non www.sito.it/23-01-2020/product-22837 ma www.sito.it/tavolini/tavolo-da-pingpong

8 – Usa il tag ALT per le immagini.

9 – Scrivi contenuti unici e fai un’analisi delle Keywords come il volume di ricerca, la competizione, il PPC medio, con i tools specifici come

![]() UBERSUGGEST che fornisce come vedremo in seguito moltissimi strumenti in parte gratuiti per esaminare il SEO di un sito (audit) e per suggerire l’utilizzo delle keywords migliori in base il volume di ricerca, il CPC, il Paid Difficulty cioè la concorrenza nella competizione in Google ADS e il SEO difficulty cioè la concorrenza nella ricerca organica)

UBERSUGGEST che fornisce come vedremo in seguito moltissimi strumenti in parte gratuiti per esaminare il SEO di un sito (audit) e per suggerire l’utilizzo delle keywords migliori in base il volume di ricerca, il CPC, il Paid Difficulty cioè la concorrenza nella competizione in Google ADS e il SEO difficulty cioè la concorrenza nella ricerca organica)

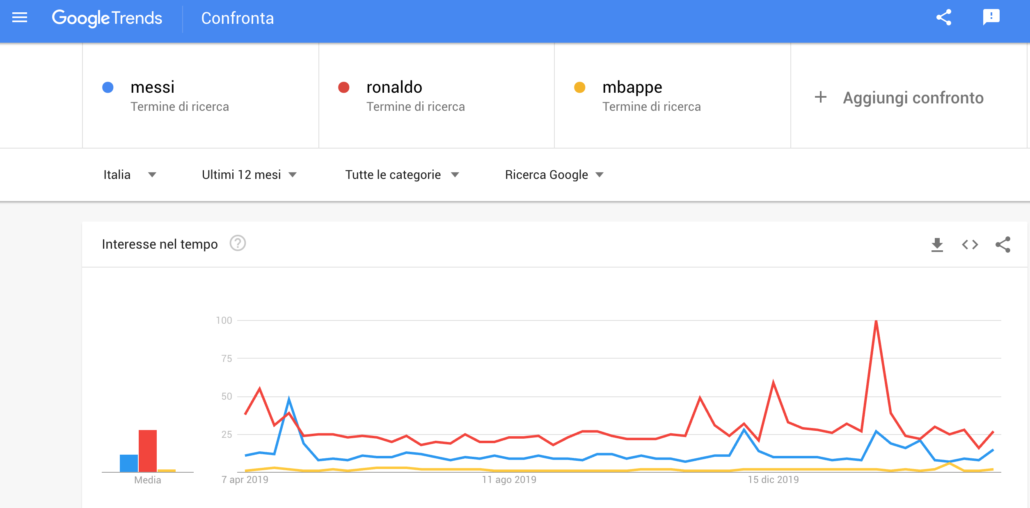

ma anche Google Trends che dentifica i vocaboli o le informazioni più cercate sul web in un certo arco di tempo o in una specifica area geografica e offre uno screening delle news più ricercate sul momento

6C – User Experience come nuovo fattore di ranking per Google

Per posizionarsi tra i primi risultati, Google non considera più soltanto gli aspetti prettamente di SEO, ma anche altri fattori. Uno di questi è l’esperienza utente. Con l’User Experience (UX) si va oltre alla semplice progettazione dell’interazione perché l’utente viene messo al centro nel processo stesso. L’interazione che l’utente ha con il prodotto dev’essere considerata come piacevole e fruibile nei migliore dei modi. Lato SEO questo significa che se i contenuti risultano obsoleti e difficilmente fruibili saranno considerati come inefficaci.

La Page Experience è un fattore di posizionamento su Google che comprende tutti gli aspetti di UX su una determinata pagina del sito web, compresi la facilità d’uso da mobile, la velocità di caricamento delle pagine e le sue prestazioni secondo i Web Core Vitals di Google. Se i siti web rispettano e soddisfano gli utenti attraverso un’eccellente Page Experience, vengono posizionati tra i primi risultati della SERP di Google. Questo perché Google preferisce dare visibilità ai siti con ottime performance e per poi classificare le varie pagine utilizzando nuovi criteri che vanno oltre al solo contenuto presente sulla pagine.

Google ha stabilito i Core Web Vitals, nuovi indicatori utili a misurare la percepibilità degli utenti sui siti che visitano.

Dono composti da tre metriche:

LCP – Largest Contentful Paint – misura il tempo di caricamento dell’elemento di contenuto visibile più grande all’interno della pagina. Bisogna garantire un punteggio LCP inferiore a 2,5 secondi dall’inizio del caricamento;

FIS – First Input Delay – misura il tempo che passa tra la prima interazione dell’utente all’interno di una pagina e il momento in cui il browser realmente risponde. Il valore FID dovrebbe essere inferiore a 100 millisecondi;

CLS – Cumulative Layout Shift – misura la stabilità visiva di una pagina, quindi tutti gli spostamenti che non sono previsti. Il punteggio per garantire una migliore esperienza utente dev’essere inferiore a 0,1.

7 – SEO ONSITE: OTTIMIZZAZIONE CODICE HTML, ROBOT.TXT E HTACCESS

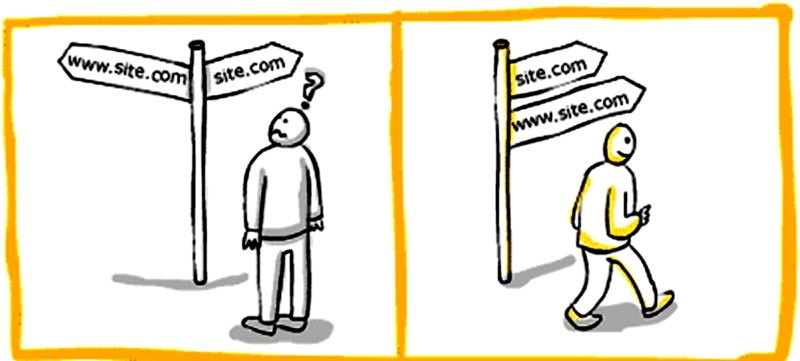

7b. Il CANONICAL. Come spiegare a Google qual è la pagina giusta da prendere in considerazione tra due simili o uguali

I canonical URL sono qualcosa di molto importante dal punto di vista SEO e sono utili anche per indicizzare meglio i propri contenuti originali senza che vengano “rubati”.

Se c’è una pagina accessibile da più URL o da pagine diverse con contenuti simili Google li vede come versioni duplicate della stessa pagina. Google sceglierà un URL come versione canonica e lo sottoporrà a scansione, e tutti gli altri URL saranno considerati URL duplicati e scansionati meno spesso.

Bisogna comunicare a Google quale URL è canonico sennò sceglierà da solo quale sarà la pagina da indicizzare!

-> Guida al Canonical di Valentino Mea

Il rel=canonical è un elemento HTML che serve a comunicare ai motori di ricerca, in presenza di due URL con contenuto identico o simile, qual è la pagina canonica, ovvero la pagina da considerarsi come “originale”.

In pratica, il rel=canonical si utilizza per evitare le duplicazioni di contenuti, che in ambito SEO possono penalizzare il ranking di un sito.

Immaginate il rel canonical come una specie di “etichetta” applicata a una pagina, che risponde alla domanda “a quale URL appartiene il contenuto originariamente?”. La risposta potrebbe essere:

->a questa stessa pagina (quindi la pagina è canonica);

-> a un’altra pagina (che invece è la pagina canonica, indicando qual è).

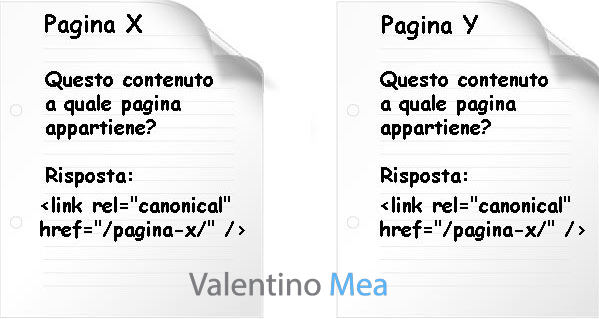

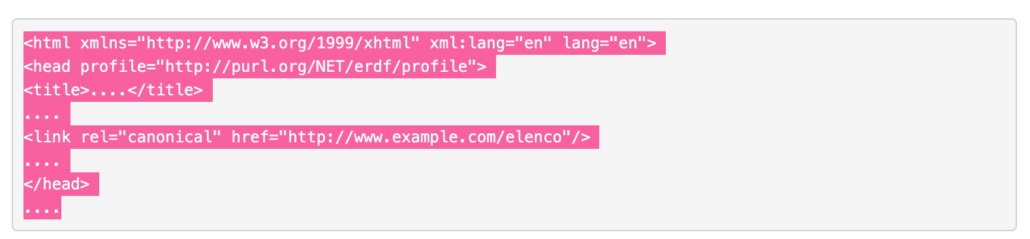

Come implementare il rel=canonical

Aggiungi nel codice della per tutte le pagine (in HEAD) duplicate un tag che indirizza gli spider dei motori di ricerca alla pagina canonica. Puoi utilizzare un tag nell’intestazione HTTP della pagina per segnalare quando una pagina è un duplicato di un’altra.

Lo stesso canonical dovrà essere utilizzato per tutte quelle pagine che non sono altro che duplicati di questa pagina:

- www.example.com/elenco avrà come canonical http://www.example.com/elenco

- www.example.com/elenco/nome avrà come canonical http://www.example.com/elenco

- www.example.com/elenco/cognome avrà come canonical http://www.example.com/elenco

- In generale:

Scegliere una delle due pagine e rendila la versione canonica inserendo nelle pagine NON canoniche la stringa

Fare in modo che la scelta ricada sulla pagina più importante

Esistono diversi motivi per cui conviene scegliere espressamente una pagina canonica in un insieme di pagine duplicate o simili:

- Specificare l’URL da mostrare nei risultati di ricerca. Gli utenti che arrivano dai motori di ricerca dovrebbero atterrare qui https://sitogomme.it/205-55-15/ e non qui https://sitogomme.it/205-55-15/?ordinamento=prezzo. Una pagina di listing potrebbe generare decine, centinaia o anche migliaia di varianti URL con gli stessi prodotti. Questa situazione per Googlebot è un inferno se non viene gestita correttamente con canonical e “Gestione parametri” in Google Search Console.

- Consolidare i segnali associati ai link per pagine simili o duplicate. Consente ai motori di ricerca di consolidare le informazioni in loro possesso in merito ai singoli URL (ad esempio, link che rimandano a tali URL) in un unico URL preferito. Ciò significa che i link presenti in altri siti che rimandano a http://sitogomme.it/205-55-15/?ordinamento=prezzo vengono consolidati con i link che rimandano a https://sitogomme.it/205-55-15/. I backlink già sono rari, se poi vengono diluiti in altre pagine senza valore si farebbe un danno SEO molto grave.

- Semplificare il monitoraggio delle metriche relative a un singolo URL. La presenza di URL multipli (normali e parametrizzati) nei report di Google Analytics o Google Search Console rende più complicato ricevere metriche consolidate per un contenuto specifico.

- Gestire i contenuti duplicati distribuiti ad altri siti web. Se distribuisci in syndication i contenuti per pubblicarli (o farli pubblicare) su altri domini, ti conviene consolidare il ranking delle pagine con il tuo URL preferito per evitare che le pagine clone vengano indicizzate e posizionate prima delle tue.

- Aiutare Googlebot a non scansionare pagine duplicate. Per ottimizzare la scansione del sito ed il crawl budget, è preferibile che Googlebot sottoponga a scansione pagine nuove (o aggiornate), anziché le versioni filtrate e duplicate di una stessa pagina. Ricordati che il tempo che Googlebot assegna alla scansione del tuo sito non è infinita.

-> https://www.evemilano.com/rel-canonical/

In caso di contenuti duplicati meglio CANONICAL o REDIRECT?

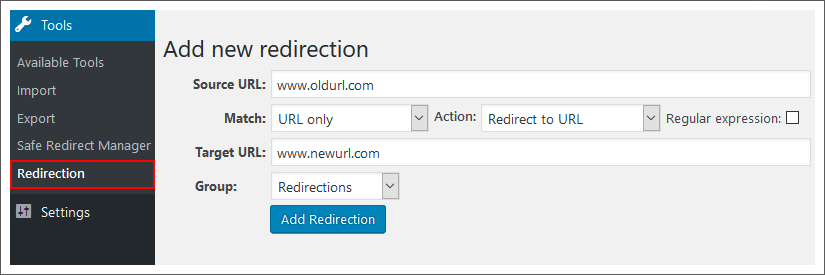

Si utilizzano i reindirizzamenti 301 per indicare a Google che un URL reindirizzato è una versione migliore dell’URL prestabilito. Si adotta questo metodo solo per rendere obsoleta una pagina duplicata. Un redirect è più veloce ed efficace del tag rel canonical, ma in certi casi non sarebbe corretto rindirizzare l’utente!

Supponiamo che sia possibile accedere alla pagina in diversi modi:

https :// sitogomme.it/home

https :// home.sitogomme.it

https :// www.sitogomme.itSi sceglie uno di questi URL come URL canonico e si utilizzano i reindirizzamenti 301 per inviare il traffico dagli altri URL all’URL preferito. Un reindirizzamento 301 lato server sul file htaccess ad esempio è il modo migliore per assicurarsi che utenti e motori di ricerca siano indirizzati alla pagina corretta. Il codice di stato 301 indica che una pagina è stata spostata definitivamente in una nuova posizione come abbiamo già appurato.

![]() Approfondisci: https://www.roberto-serra.com/canonical-url-cose-e-perche-non-puoi-farne-a-meno-lato-seo/

Approfondisci: https://www.roberto-serra.com/canonical-url-cose-e-perche-non-puoi-farne-a-meno-lato-seo/

7c. Mappa del sito e architettura delle informazioni

Un altro elemento importante riguarda la struttura del sito o mappa del sito stesso ottimale se gerarchica perché facilmente scansionabile dai robot.

Un esempio di struttura “ad albero” comprensibile per i motori di ricerca.

Bisogna anche verificare ed eventualmente sistemare la presenza di link non funzionanti all’interno del nostro sito, poiché un numero eccessivo di “broken link” può far supporre ai motori che il sito sia abbandonato.

Per approfondire leggi anche come ottimizzare la meta tag description e come ottimizzare il tag title. Puoi anche leggere questa guida all’ottimizzazione del codice HTML di STUDIO SAMO.

LA SITEMAP

Per creare una mappa in XML, RSS, TESTO:

https://support.google.com/webmasters/answer/183668?hl=it

es. per un singolo URL

xml version="1.0" encoding="UTF-8"?>

xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

http://www.example.com/foo.html

2018-06-04

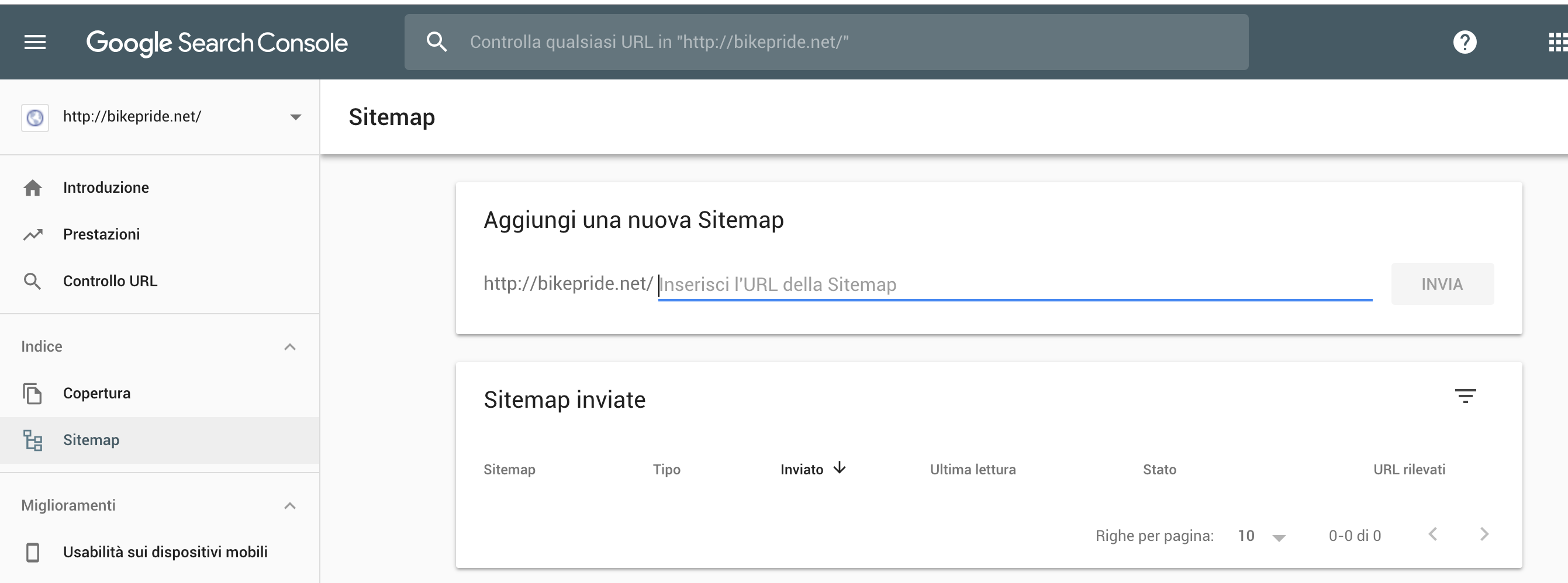

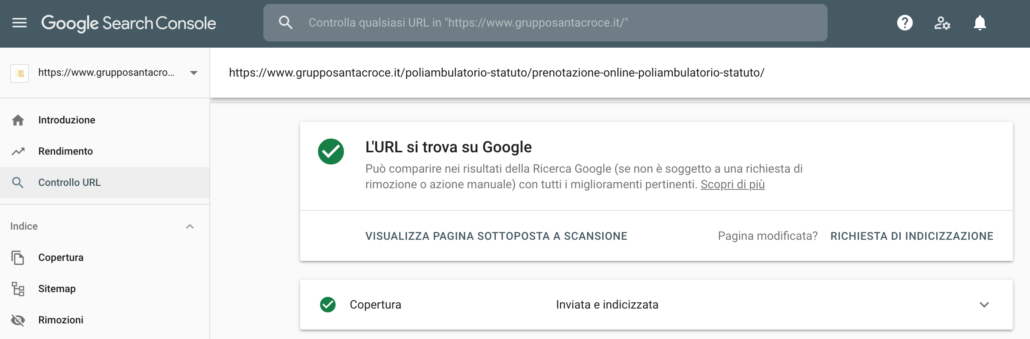

Come caricarla sul sito e renderla utile per il SEO

-> Utilizzare Google Search Console -> Mappa del Sito

-> Caricarla con un plugin del proprio CMS (es. per wordpress YoastSeo)

Esistono per fortuna dei generatori automatici di sitemap in XML come: https://www.xml-sitemaps.com/

Architettura delle informazioni

A proposito di sitemap, fondamentale è che il sito web risponda ad una struttura ed una architettura delle informazioni ordinata!

Una buona struttura facilita agli utenti navigare tra le pagine del tuo sito e ai motori di ricerca scansionarne i contenuti e capire di cosa tratta.

Pensa a come le pagine del tuo sito web si relazionano tra loro, in particolare come si diramano dalla tua home page e si raggruppano in directory più complesse.

Pianificare una struttura del sito include considerare:

- Strutture degli URL

- Menu di navigazione

- Categorizzazione

- Breadcrumbs

- Internal linking

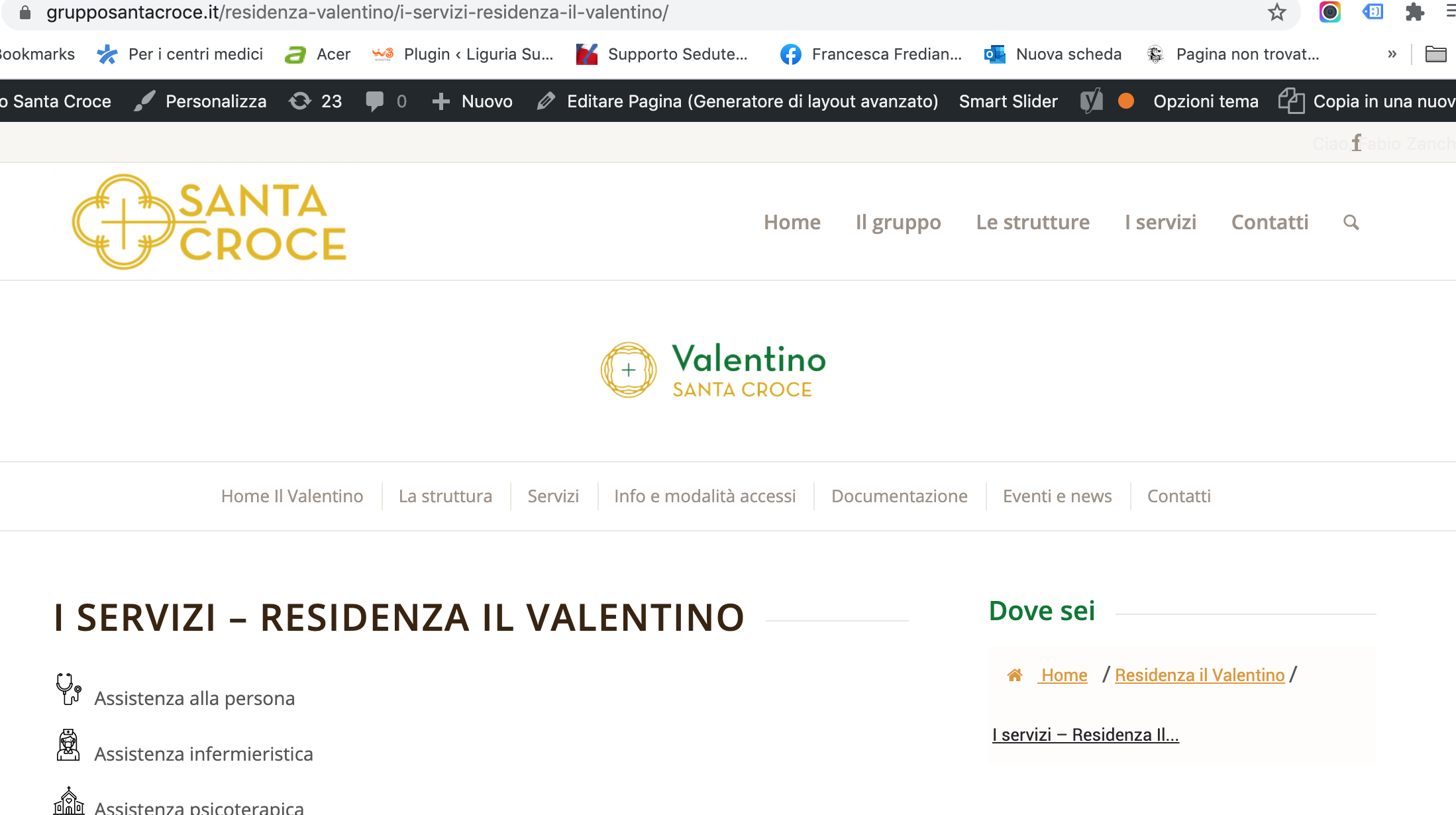

In questo caso sitogruppostrutturemediche.it/nome-struttura/servizio-dellastruttura

+ bread crumb

+ h1

I backlink sono un fattore di ranking chiave. Per massimizzare i vantaggi della tua strategia di link building, devi assicurarti di distribuire correttamente la link authority in tutto il tuo sito (questa pagina del sito fabiozanchetta.it sul SEO non è ben ottimizzata SEO perché non rìsponde all’ordinamento per cluster)

Per guadagnare backlink di alta qualità, devi avere pagine diverse che rispondano a domande diverse. In questo modo, avrai diverse pagine sul tuo dominio vantaggiose per gli utenti. E potrai anche acquisire backlink più pertinenti e di qualità.

in astratto:

Leggi: https://it.semrush.com/blog/struttura-di-un-sito-per-la-seo/

7d. Le relazioni: Nofollow – Noindex

L’indicizzazione delle pagine web (e anche la deindicizzazione delle pagine web) dipende dai meta tag robots, che comunicano ai motori di ricerca varie informazioni (ad esempio che keywords scelte, i titoli delle pagine, la natura dei link) nonché la nostra scelta di indicizzare o meno una pagina, di inserirla negli archivi dei motori di ricerca e di dare o meno importanza ai link contenuti sulla pagina.

Noindex/index

L’attributo rel=”noindex” comunica a Google la nostra intenzione di non voler indicizzare la pagina, anche se non è detto che Google segua le nostre direttive.

In questo modo la pagina non esisterà più per i motori di ricerca, ma gli utenti continueranno a visualizzarla: questo farà sì che non si accumulino sul nostro sito delle spam engine, ma al tempo stesso eviterà che i backlink esterni e quelli interni rimandino ad una pagina 404.

Nofollow/follow

L’attributo rel=”nofollow” agisce in maniera diversa rispetto al noindex che, come abbiamo visto, serve a deindicizzare una pagina.

Il nofollow indica a Google di non seguire i link contenuti in una pagina specifica, né di dar loro peso in termini di posizionamento, attribuendo valore al sito che riceve i link.

Questi meta tag, inseriti nella head della pagina HTML, è dato dal seguente codice:

meta name=”robots” content=”nofollow“

Il valore per l’attributo content definisce l’istruzione allo spider relativo alla pagina:

-

- index – si richiede di indicizzare la pagina (di inserirla cioè nell’archivio del motore di ricerca);

-

- noindex – si richiede di non includere la pagina negli archivi del motore di ricerca;

-

- follow – si richiede che tutti i link presenti nella pagina vengano seguiti; questo consente anche il passaggio di valore da una pagina all’altra, come avremo modo di vedere in modo molto ampio;

-

- nofollow – si richiede di non seguire i link che da quella pagina puntano verso altre pagine.

Questo metatag si distingue dal file robots.txt perché si riferisce alla singola pagina in cui è presente, e non al sito nel suo complesso e quindi il crawler agirà solo su quella pagina.

I valori relativi all’indicizzazione (index/noindex) e quelli relativi ai link (follow/nofollow) possono essere combinati tra loro.

Abbiamo così quattro alternative:

I valori relativi all’indicizzazione (index/noindex) e quelli relativi ai link (follow/nofollow) vengono combinati tra loro.

Abbiamo così quattro alternative:

meta name=”robots” content=”index, follow“

Si richiede di indicizzare la pagine e seguire tutti i link.

meta name=”robots” content=”index, nofollow“

Si richiede di indicizzare la pagina ma non seguire i link.

meta name=”robots” content=”noindex, follow“

Si richiede di non indicizzare la pagina, ma di seguire i link che da quella pagina portano ad altre pagine.

meta name=”robots” content=”noindex, nofollow“

Si richiede allo spider di non indicizzare e non seguire i link di quella pagina.

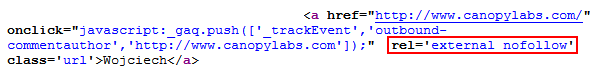

Quando si cercando di produrre backlink con il link building/earning è fondamentale verificare se ci sono dei nofollow.

Il nofollow è un attributo che – si può dire – impedisce al link juice di fluire ad un sito web. Questa è una cosa molto comune ad esempio nei link presenti nella sezione commenti di un blog.

Per scoprire se i link che puntano al tuo sito passano il succo del collegamento, devi verificare se i link hanno l’attributo nofollow al loro interno. Se ce l’hanno, allora il link che hai lavorato così duramente per ottenere non sta facendo molto per te, in quanto l’attributo nofollow dice fondamentalmente a Google di ignorare la tua pagina web.

Nell’immagine qui sopra vediamo che è possibile inserire l’istruzione nofollow per singoli link. Questo può essere utile se vogliamo ad esempio permettere allo spider di seguire i link della pagina, tranne alcuni specifici.

Per farlo possiamo utilizzare l’attributo rel=”nofollow” del tag relativo al singolo link.

Es.:

a href=”http://www.altrosito.it” rel=”nofollow”>Altrosito

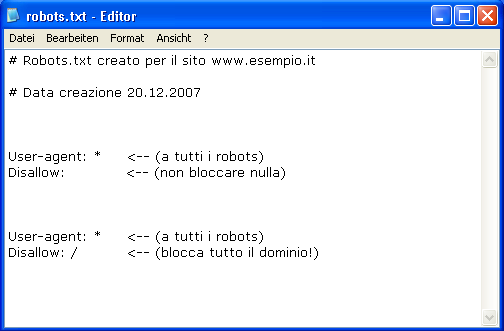

Perché usare noindex se abbiamo il disallow su Robots.txt? Il file robots.txt impedisce del tutto l’accesso dello spider a determinate cartelle e file tramite l’istruzione Disallow, mentre il meta tag robots permette in ogni caso l’accesso alla pagina, istruendo lo spider sulla fase successiva: se indicizzare o meno la pagina, se deve seguire o meno i link; si tratta di un metodo che permette di istruire in modo ancora più preciso e specifico lo spider.

ROBOTS.TXT

Il robots.txt è un file di testo che permette al Webmaster di fornire una serie di istruzioni ai motori di ricerca riguardo ciò che possono e ciò che non possono fare all’interno del nostro sito.

Queste istruzioni seguono il cosiddetto Robots Exclusion Protocol (REP), le cui specifiche sono disponibili sul sito www.robotstxt.org .

Il file robots si presenta nel formato txt e codifica UTF-8 e contiene alcune semplici istruzioni.

Un’istruzione base allo spider è dato da due righe:

– User-agent

Questo elemento specifica a quale spider si applica l’istruzione.

User-agent: *

con * (asterisco) si indica che l’istruzione riguarda tutti gli spider .

Se vogliamo specificare l’istruzione ad uno spider preciso, dovremmo scrivere il nome dello spider. Nel caso di Google lo spider principale è Googlebot.

Scriveremo quindi:

User-agent: Googlebot

L’elenco dei nomi degli spider è disponibile su robotstxt.org.

– Disallow

La riga definita dal valore Disallow dice allo spider quale cartella o file del sito non deve essere visto e indicizzato; serve di fatto ad impedirne l’accesso.

Ipotizziamo di avere una cartella /admin contenente aspetti relativi all’area amministrativa del sito e di volere impedire che venga visto dallo spider. Scriveremo:

User-agent: *

Disallow: /admin/

Possiamo invece impedire, ad esempio, l’indicizzazione su Google Immagini di una cartella contenente le immagini: ad esempio la cartella /immagini del nostro sito (www.miosito.it/immagini).

Scriviamo:

User-agent: Googlebot-Image

Disallow: /immagini/

Possiamo dare istruzioni relative ad un singolo file. In questo caso scriveremo, ad esempio:

User-Agent: *

Disallow: /immagini/foto1.jpg

Allow

Possiamo anche utilizzare il termine Allow per permettere la visione e l’indicizzazione di alcune pagine o cartelle.

Può essere utile se abbiamo impedito l’accesso ad una cartella (ad esempio la cartella /immagini) ma vogliamo permettere l’indicizzazione di un file al suo interno (ad esempio il file /immagini/foto1.jpg).

Scriveremo:

User-Agent: Googlebot-Image

Disallow: /immagini/

Allow: /immagini/foto1.jpg

In questo caso impediamo la scansione e l’indicizzazione di tutti i file contenuti dentro la cartella /immagini tranne che per il file foto1.jpg .

Carattere * e $

Il carattere * , rispettato dagli spider di Google e Bing, è utilizzato non solo a livello dell’User-agent (qui sta a significare “tutti gli spider”) ma anche al livello di Disallow, anche insieme ad un secondo carattere accettato $.

Vediamo l’utilizzo di entrambi i caratteri.

Ipotizziamo di voler escludere tutti i file nel formato jpg dalla scansione dello spider.

Scriviamo:

User-Agent: *

Disallow: /*.jpg$

in questo modo indichiamo che tutti i file che terminano con .jpg devono essere esclusi dalla scansione dello spider.

Lo stesso potremo fare, ad esempio, per i file pdf.

User-Agent: *

Disallow: /*.pdf$

Potremmo invece permettere ad esempio l’accesso e la scansione di un file PDF specifico (ad esempio documento1.pdf)

Scriveremo:

User-Agent: *

Disallow: /*.pdf$

Allow: /documento1.pdf

Il carattere * può essere utilizzato anche in altre situazioni.

Ipotizziamo di voler impedire l’accesso degli spider a più cartelle con nomi simili. Ad esempio:

/immagini-mare

/immagini-montagna

/immagini-citta

Possiamo scrivere un’unica regola che impedisca l’accesso a tutte quelle cartelle o sottocartelle che iniziano con il nome “immagini”.

Scriveremo così:

User-Agent: *

Disallow: /immagini*/

Un altro utilizzo dell’asterisco * è quello di bloccare l’accesso a tutti gli URL che comprendono un determinato carattere.

Ad esempio il ? (punto interrogativo).

Scriveremo così:

User-Agent: *

Disallow: /*?

HTACCESS

Il file htaccess (hypertext access) è un semplice file di testo che permette di raffinare, a livello di directory, le direttive per la configurazione di Apache HTTP Server: la piattaforma web server più diffusa al mondo.

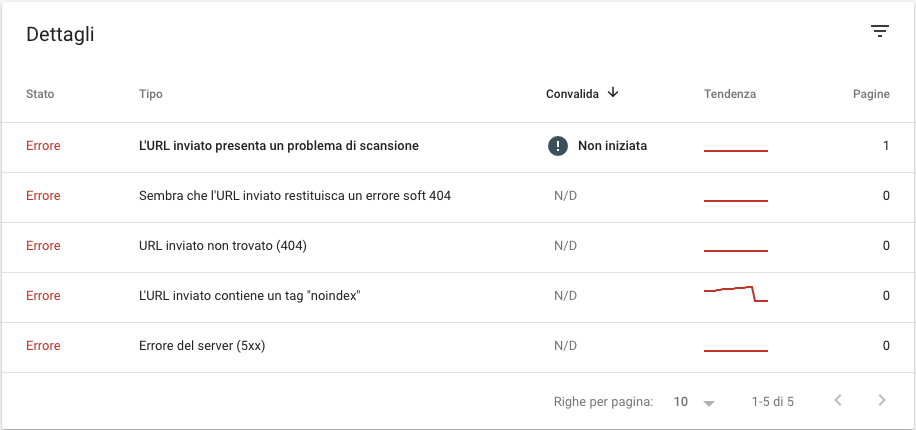

In particolare per comprendere quali redirect è opportuno realizzare mediante il file .htaccess uno strumento FONDAMENTALE, da configurare per i nostri siti web, è la Google Search Console. L’ex tool per webmaster di Google ci mostrerà, nella sezione dedicata agli Errori causati da URL (dopo aver fatto accesso a GSC e aver selezionato la proprietà da analizzare dal menù laterale Scansione >> Errori di scansione) tutte le pagine che il motore di ricerca si aspetta di trovare e che al contrario emettono un codice di risposta erroneo, come ad esempio il 404 contenuto non trovato, e su cui è opportuno effettuare dei redirect a contenuti esistenti, ottimizzando così la SEO del prodotto su cui stiamo lavorando.

Modificare l’.htaccess è un’azione molto delicata e che va effettuata solo dopo diverse prove su prodotti di test!

Alcune tecniche SEO grazie al file .htaccess

Vediamo nel dettaglio cosa possiamo fare per migliorare il posizionamento delle nostre pagine sui motori di ricerca, applicando alcuni concetti SEO di base al nostro sito, mediante il file .htaccess.

Vediamo nel dettaglio cosa possiamo fare per migliorare il posizionamento delle nostre pagine sui motori di ricerca, applicando alcuni concetti SEO di base al nostro sito, mediante il file .htaccess.

Riscrittura degli URL

Realizzare degli URL semplificati agli occhi dell’utenza è un’ottima tecnica di base al fine di ottimizzare la SEO on-page di un sito web. Per questo motivo è necessario realizzare dei permalink di facile comprensione, che non abbiano caratteri speciali al loro interno (a parte i caratteri - o _), senza l’estensione del file e possibilmente brevi e incisivi.

Vediamo due veloci esempi di questa applicazione, entrambi per funzionare richiedono che il nostro server Apache abbia attivato il supporto per il mod_rewrite.

Riscrittura dell’URL con elisione dell’estensione

Se le pagine del nostro sito hanno un indirizzo del tipo http://www.sitoesempio.tlp/pagina-esempio.html possiamo riscrivere l’URL in chiave SEO http://www.sitoesempio.tlp/pagina-esempio.

Il codice da inserire nell’.htaccess sarà il seguente:

RewriteEngine on

RewriteRule ^(.*)$ $1.html

Alcuni esempi di Redirect

1) Reindirizzamento da WWW a senza WWW:

RewriteEngine OnRewriteBase /RewriteCond %{HTTP_HOST} ^www.(.*)$ [NC]RewriteRule ^(.*)$ http://%1/$1 [R=301,L] |

2) Redirect da senza WWW a WWW:

RewriteEngine OnRewriteCond %{HTTP_HOST} !^www.RewriteRule ^(.*)$ http://www.%{HTTP_HOST}/$1 [R=301,L] |

(altro codice stesso risulato)

RewriteEngine OnRewriteCond %{HTTP_HOST} ^tuodominio.it [NC]RewriteRule ^(.*)$ http://www.tuodominio.it/$1 [L,R=301] |

3) Redirect da vecchio dominio a nuovo dominio

RewriteEngine OnRewriteCond %{HTTP_HOST} !^www.vecchiodominio.com$RewriteRule (.*) http://www.nuovodominio.com/$1 [R=301,L]RewriteCond %{HTTP_HOST} !^vecchiodominio.com$RewriteRule (.*) http://www.nuovodominio.com/$1 [R=301,L] |

(altro codice stesso risulato)

RewriteCond %{HTTP_HOST} ^(www.)?vecchio-dominio.com [NC] RewriteRule (.*) http://nuovo-dominio.com/$1 [R=301,L] |

4) Redirect da vecchio sotto dominio a nuovo sotto dominio

RewriteEngine OnRewriteBase /RewriteCond %{HTTP_HOST} ^sottodominio.vecchio.com$ RewriteRule ^(.*)$ http://sottodominio.nuovodominio.com/$1 [R=301,L] RewriteCond %{HTTP_HOST} ^www.sottodominio.vecchiodominio.com$ RewriteRule ^(.*)$ http://sottodominio.nuovodominio.com/$1 [R=301,L] |

5) Redirect da vecchio dominio a nuovo sotto dominio

RewriteEngine onRewriteRule ^(.*)$ http://www.your-new-domain.com/$1 [R=301,L] |

OPPURE PROVARE:

Options +FollowSymLinksRewriteEngine onRewriteRule (.*)$ http://www.nuovosito.com/$1 [R=301,L] |

6) Redirect da vecchia cartella verso nuova cartella:

RewriteRule ^vecchiacartella/(.*)$ /nuovacartella/$1 [R=301,NC,L] |

7) Redirect da cartella a nuovo dominio ma stessa cartella:

Redirect 301 /cartella http://www.nuovodominio.com/stessacartella |

8) Redirect da cartella verso la cartella root principale:

RewriteRule ^cartella/(.*)$ /$1 [R=301,NC,L] |

Di seguito un esempio contenuto all’interno di un file htaccess che include il codice di default di wordpress e un redirect 301.

# BEGIN WordPressRewriteEngine OnRewriteBase /RewriteRule ^index.php$ - [L]RewriteCond %{REQUEST_FILENAME} !-fRewriteCond %{REQUEST_FILENAME} !-dRewriteRule . /index.php [L]# END WordPress#redirectredirect 301 /vecchio-link http://www.miosito.it/nuovo-link. |

8 – PAGE RANK

Anche se è fondamentale avere pagine ottimizzate, raramente ciò è sufficiente per ottenere i risultati desiderati. L’ottimizzazione off-page (al di fuori delle nostre pagine), riguarda essenzialmente la gestione dei link su altri siti che puntano al nostro.

Negli anni 90′, i due fondatori di Google, Larry Page e Sergey Brin, basarono il loro successo sulla convinzione che le pagine citate con un maggior numero di link fossero le più importanti e meritevoli. Questa fu la vera grande innovazione di Google, che cambiò per sempre il mercato della ricerca su internet. Agli occhi di Google, un collegamento a una pagina è essenzialmente un “voto” per il suo contenuto, esprime in altre parola la volontà, da parte del webmaster o proprietario di un sito, di citare una risorsa importante e degna di essere visitata dagli utenti.

La logica conseguenza di questa premessa è che uno dei principali fattori che incide sulla classifica di Google è il numero di link che puntano verso un sito. Tuttavia, l’importanza di un sito non è interamente calcolata sulla quantità di link ricevuti. Google considera infatti anche l’importanza della pagina di provenienza del link. Un link da una pagina di un sito autorevole vale di più di uno da un sito di scarsa qualità. E’ quindi teoricamente possibile essere posizionati meglio di un concorrente con un minor numero di link, se questi sono di qualità sufficientemente alta.

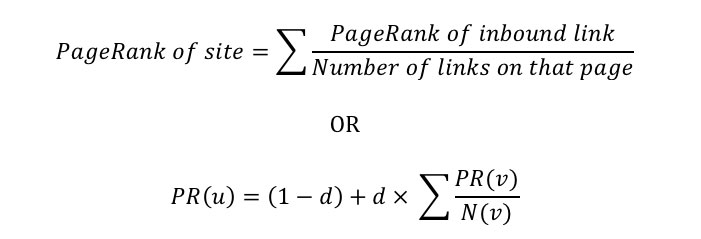

Per calcolare l’importanza di una pagina, e di conseguenza la qualità di un link, Google ha ideato una formula che si chiama PageRank, un “voto” da 0 a 10 che assegna ad ogni pagina web in base al numero di link verso quella pagina. La formula del PageRank, per anni rimasta segreta, è stata poi divulgata da Google. Di seguito riporto una versione semplificata della formula:

Versione semplificata della formula del PageRank

Dove:

— PR (u) è il valore di PageRank della pagina u che vogliamo calcolare.

— PR (v) è il valore di PageRank di ogni pagina che collega la pagina u.

— N (v) è il numero complessivo di link contenuti nella pagina dove sta il link.

— d (damping factor) è un fattore stabilito da Google e che rappresenta la possibilità degli utenti di non seguire nessun link. Di norma assume il valore di 0,85, ma può essere modificato da Google nei singoli casi.

Dalla formula si nota quindi che all’aumentare del numero di link complessivi dei siti che puntano ad u, il PageRank aumenta, ma dipende anche dal PageRank delle singole pagine che linkano u e dal numero di link in uscita da quelle pagine.

Semplificando ulteriormente, possiamo dire che più alto è il valore di PageRank delle pagine che ci linkano e la quantità di pagine che ci linkano, più alto sarà di conseguenza il nostro PageRank. Un alto PageRank, sebbene meno importante rispetto al passato, è ancora un fattore che Google tiene in considerazione per posizionare le pagine nella sua classifica.

Oltre a considerare quantità e qualità dei link ricevuti, ci sono altri fattori legati ai link che incidono sul posizionamento organico. Oltre ad essere un “voto” di qualità, il link è infatti – per i motori di ricerca – anche una informazione tematica. Tenendo a mente questo, sono due i fattori che determinano il valore di ciascun link che punta al nostro sito: il tema della pagina di provenienza e l’anchor text del link. Perché un link in entrata (verso il nostro sito) abbia un effettivo valore per noi, dovrà provenire da una pagina che tratta lo stesso tema (o il più attinente possibile) trattato nella nostra pagina.

Per lo stesso motivo, l’anchor text, che è la parola o le parole che formano il link (quindi quelle cliccabili) dovrà essere pertinente col tema che stiamo trattando. Per esempio, se il nostro obiettivo è posizionarci con la parola chiave “posizionamento su Google“, il massimo del valore per noi è di ricevere link con l’anchor text contenente le parole “posizionamento su Google“, ossia la nostra keyword di riferimento. In questo modo, il motore di ricerca considererà la nostra pagina pertinente con quella query.

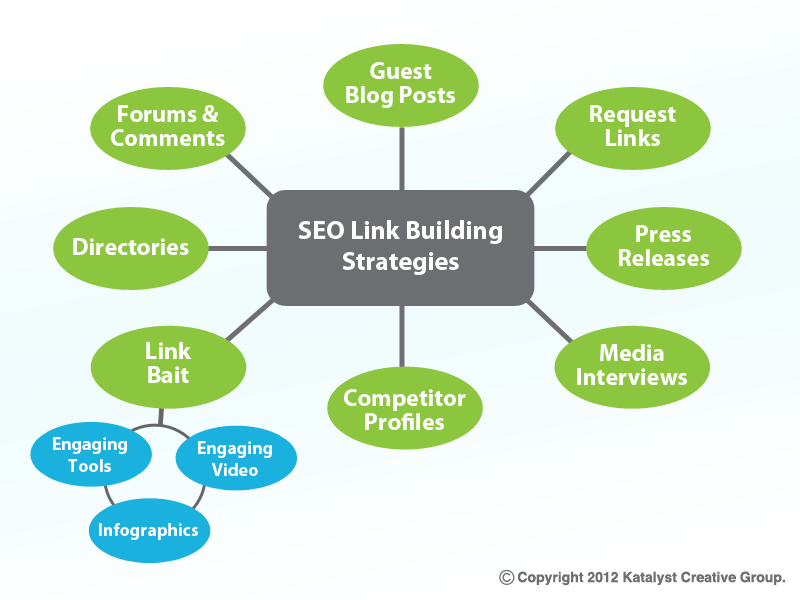

L’attività “off-page” consiste quindi per lo più nella gestione della link pupularity (popolarità da link), ed è una parte molto importante del processo. Questa parte è spesso più lunga e difficoltosa di quella “on-page”, poiché non abbiamo il controllo diretto sui siti degli altri. Per gestire la link popularity occorre, come abbiamo detto, ottenere link verso il proprio sito da altri siti pertinenti e rilevanti rispetto alla tematica trattata dal sito, ma come fare?

9 – SITI PENALIZZATI?

Siti penalizzati (da google) con il cambiamento di algoritmo?

Negli ultimi anni Google ha lavorato davvero parecchio per combattere ogni forma di spam e per garantire ai propri utenti i migliori risultati di ricerca. Le penalizzazioni SEO, infatti, esistono proprio per fare in modo che i gestori dei siti web operino per il bene degli utenti, senza cercare delle scorciatoie barbine per arrivare in cima alle SERP con dei contenuti scadenti o, quanto meno, non eccellenti.

Ecco quali sono alcuni punti (riassunti) elencati da Roberto Serra nel post di cui sopra:

1. Contenuti di bassa qualità. i nuovi algoritmi di Google vanno a cercare dei contenuti superficiali, che non portano nulla o poco di utile all’utente. Una volta individuati, vengono penalizzati. Google analizza come si comportano gli utenti sul sito attraverso dati facilmente raggiungibili dal tool analytics.. se hai un altissimo tasso di rimbalzo (bounce rate) penalizzerai anche la seo del sito.

2. Keyword stuffing. la keyword stuffing riguarda ripetizioni esagerate delle medesime parole chiave all’interno della pagina o nel sito.

3. Testi nascosti. Google non tollera più da tempo testi invisibili!

4. Pagine e contenuti clonati. Google penalizza qui siti che utilizzano in parte o per intero dei contenuti copiati da altri domini (anche se si usano sinonimi!). I link canonici verranno premiato.

5. Contenuti inutili. Non ha senso avere micro pagine che si ripetono, Google le penalizza!

6. Troppi errori grammaticali. Google tiene parecchio alla grammatica e alla scorrevolezza di un testo, ed è pronto a penalizzare concretamente le pagine che contengono errori!

7. Ancore dei link troppo ottimizzate. Infastidito da tutti quei SEO che, per spingere il proprio sito web, fabbricavano ad hoc migliaia di pagine che avevano la sola funzione di creare dei backlink, Google ha iniziato ad analizzare ben bene questi link. Tra le cose che va a controllare c’è l’ancora, ovvero il testo cliccabile che conduce al sito di atterraggio: se Google trova troppe ancore che hanno un match esatto o molto simile con la keyword che il sito di arrivo sta cercando di ottimizzare, inizia a insospettirsi.

8. Troppi link da siti di scarsa qualità. Non si può obbligare chi ha un sito di bassa qualità di non linkare al nostro sito.. ma il fatto di avere troppi backlink di questo tipo può voler dire che anche il nostro sito ha una qualità scarsa. Cosa significa tutto questo? Secondo il SEO Serra i backlink di bassa qualità non devono superare il 70% o il 75% del totale.

9. Troppi link provenienti da fonti non rilevanti-coerenti. Google si accorge se il tuo sito che si occupa di web marketing ha troppi backlink che parlano di bitcoin.. e potrebbe penalizzarti.

10. I link acquistati. .Non appena Google penserà che tu hai pagato qualcuno per linkare il tuo sito, infatti, partiranno delle penalizzazioni SEO.

11. Scambi troppo importanti di link. È del tutto normale linkare un sito e, dopo poco tempo, ricevere un backlink dal medesimo portale. Ma Google potrebbe storcere il naso quando gli scambi sono troppi e assomigliano a dei baratti

12. Assenza di link che puntano verso l’esterno. I siti che non linkano a nulla verso l’esterno non contribuiscono a rendere più facile la navigazione per gli utenti. E non fanno di certo meglio i siti che si limitano a inserire solamente dei link no-follow.

14. Troppi banner. Non c’è un limite assoluto per quanto riguarda gli ads che possono essere presenti in una pagina, ma di certo una pagina con pochissimi contenuti non potrà contenerne più di uno.

10 – OFF PAGE SEO E LINK BUILDING

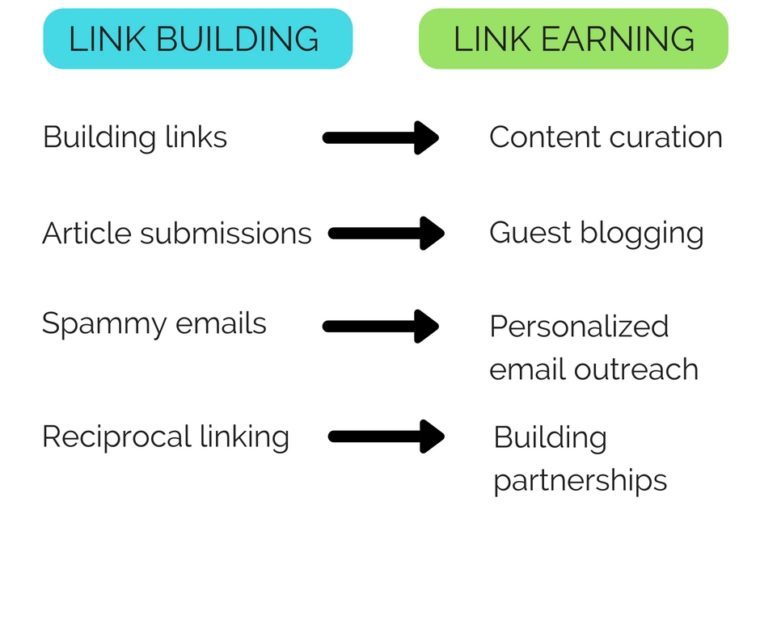

Link earning vs link building

“Linkare” significa dire a Google che la pagina linkata è rilevante per quella una data keyword o key-phrase.

Una buona link strategy nella SEO ti da il potere di influenzare i motori di ricerca, dunque di apparire al meglio su Google.

Poiché i link sono segnali di interesse, risulta evidente che ottenere dei link è una naturale conseguenza dell’avere contenuti di qualità sul proprio sito. Ma d’altro canto, l’acquisizione di link inseriti spontaneamente potrebbe risultare un processo lento.

Per questo motivo, molti SEO hanno negli anni ideato diverse tattiche per ottenere link da altri siti in maniera non spontanea. L’insieme di queste tattiche prende il nome di link building (costruzione di link).

Nel mondo del SEO, ottenere un link da un altro sito web al tuo sito è un grande risultato. Tale legame è visto dai motori di ricerca come un’approvazione. I motori di ricerca considerano come fattore il numero di link che puntano al tuo sito, quando determinano il posizionamento del tuo sito nei loro indici. “Link Juice” è un termine non scientifico per il cosiddetto potere che il link fornisce al tuo sito web o pagina web in questione.

Queste tecniche, soprattutto in alcuni settori molto competitivi, sono state utilizzate in maniera eccessiva, arrivando ad essere fenomeni di spam. C’è stato un tempo in cui pratiche come scambio link, link spam su blog e forum, iscrizione compulsiva a directory (liste di link) di dubbia qualità erano pratiche all’ordine del giorno, e funzionavano molto bene per la SEO.

Per arginare questi fenomeni manipolatori, Google aggiorna costantemente i suoi algoritmi di ranking, introducendo nuovi e sempre più sofisticati sistemi per individuare link non naturali – il più famoso dei quali è l’algoritmo chiamato Penguin – o altre tecniche di spam, e prendere provvedimenti di conseguenza, ovvero penalizzare i siti che fanno uso di queste pratiche nelle sue classifiche.

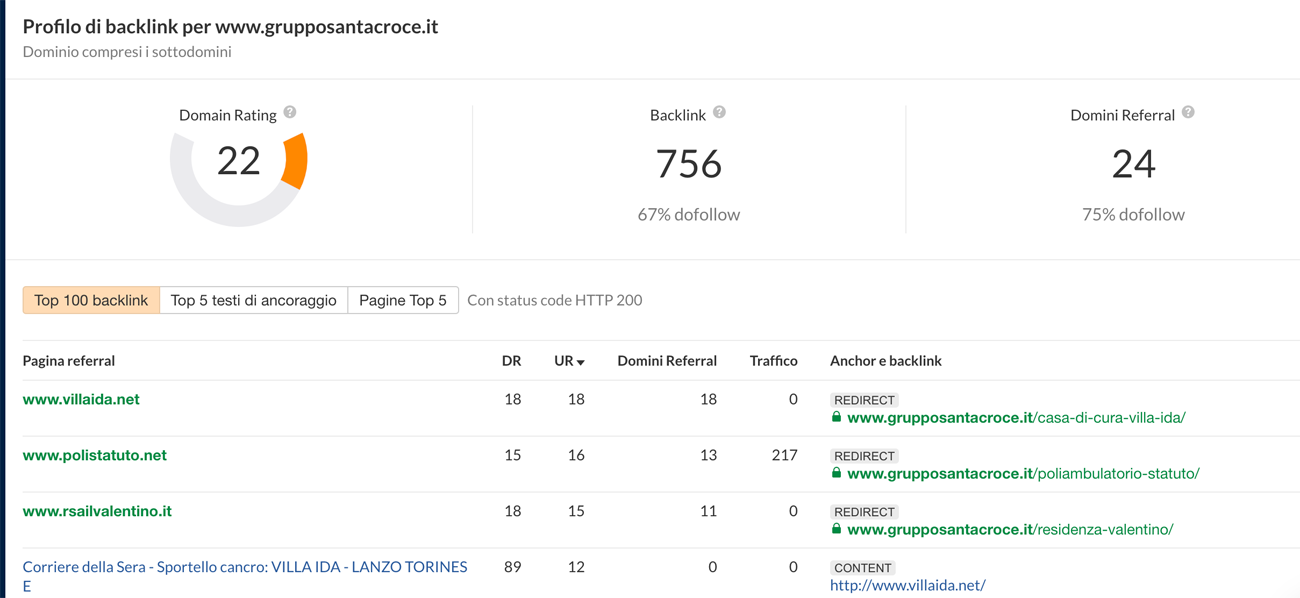

Analisi dei tuoi backlink

Fra i tanti sistemi di analisi dei backlink consiglio quello di ahrefs che visualizza tutti i backlink e ne associa un punteggio di autorità

https://ahrefs.com/it/backlink-checker

COSA DICE SEMRUSH Su come costruire una strategia di link building:

-> https://it.semrush.com/blog/14-strategie-di-link-building-scelte-dai-professionisti-nel-2020/

Al sondaggio hanno preso parte specialisti di quattro professioni: imprenditori – 38,29%; specialisti interni (in-house) – 30,24%, consulenti SEO / liberi professionisti – 22,44%; e specialisti SEO che lavorano in agenzia – 9,02%.